配置和管理逻辑卷

配置和管理 LVM 逻辑卷指南

摘要

使开源包含更多

红帽承诺替换我们的代码、文档和网页属性中存在问题的语言。我们从这四个术语开始: master、slave、blacklist 和 whitelist。这些更改将在即将发行的几个发行本中逐渐实施。如需了解更多详细信息,请参阅 CTO Chris Wright 信息。

对红帽文档提供反馈

我们感谢您对文档提供反馈信息。请让我们了解如何改进文档。要做到这一点:

关于特定内容的简单评论:

- 请确定您使用 Multi-page HTML 格式查看文档。另外,确定 Feedback 按钮出现在文档页的右上方。

- 用鼠标指针高亮显示您想评论的文本部分。

- 点在高亮文本上弹出的 Add Feedback。

- 按照显示的步骤操作。

要提交更复杂的反馈,请创建一个 Bugzilla ticket:

- 进入 Bugzilla 网站。

- 在 Component 中选择 Documentation。

- 在 Description 中输入您要提供的信息。包括文档相关部分的链接。

- 点 Submit Bug。

第 1 章 逻辑卷

卷管理会在物理存储上创建一个提取层,以便您创建逻辑存储卷。这比直接使用物理存储的方式具有更大的灵活性。另外,软件隐藏了硬件存储配置,因此可在不停止应用程序或卸载文件系统的情况下重新定义大小并进行移动。这可降低操作成本。

与直接使用物理存储相比,逻辑卷具有以下优势:

灵活的容量

当使用逻辑卷时,文件系统可在多个磁盘间扩展,您可以将磁盘和分区集合成一个逻辑卷。

重新调整存储池的大小

您可以使用简单软件命令扩展或者减少逻辑卷大小,而无需重新格式化并重新分区基本磁盘设备。

在线数据重新定位

部署更新、更快或者更弹性的存储子系统,可以在系统活跃时移动数据。在磁盘处于使用状态时可以重新分配磁盘。例如,您可以在删除热插拔磁盘前将其清空。

方便的设备命名

可在用户定义的和自定义的组群中管理逻辑存储卷。

磁盘条带

您可以创建一个在两个或者多个磁盘间条状分布数据的逻辑卷。这可显著提高吞吐量。

镜像卷

逻辑卷为您提供了方便配置数据镜像的方法。

卷快照

使用逻辑卷,您可以提取设备快照,这样可在持续备份或者在不影响真实数据的情况下测试修改效果。

精简卷

逻辑卷可以使用精简模式置备。这可让您创建大于可用扩展的逻辑卷。

缓存卷

缓存逻辑卷使用由快速块设备(比如 SSD 驱动器)组成的小逻辑卷,通过存储在较小的、更快的逻辑卷中存储常用的块来提高更大的、较慢的逻辑卷性能。

1.1. LVM 构架概述

LVM 逻辑卷的基本物理存储单元是块设备,比如一个分区或者整个磁盘。将这个设备初始化为 LVM 物理卷(PV)。

要创建 LVM 逻辑卷,可将物理卷合并到 卷组(VG)中。这会创建一个磁盘空间池,用于分配 LVM 逻辑卷(LV)。这个过程和将磁盘分区的过程类似。逻辑卷是被文件系统和应用程序(比如数据库)使用的。

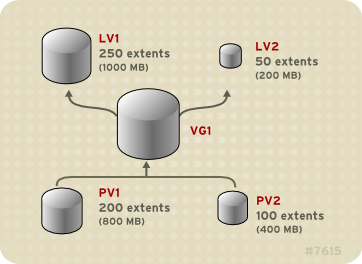

图 1.1 “LVM 逻辑卷组件” 显示一个简单 LVM 逻辑卷的组件:

图 1.1. LVM 逻辑卷组件

1.2. 物理卷

LVM 逻辑卷的基本物理存储单元是块设备,比如一个分区或者整个磁盘。要将设备作为 LVM 逻辑卷使用,需要首先将其初始化为物理卷(PV)。将块设备初始化为物理卷会在接近设备起始的位置放置一个标签。

默认情况下,LVM 标签是放在第二个 512 字节扇区。您可在创建物理卷时将标签放在前四个扇区之一来覆盖这个默认设置。如果需要,LVM 卷可与其它使用这些扇区的用户共同存在。

LVM 标签可为物理设备提供正确的识别和设备排序,因为在引导系统时设备可以按任意顺序出现。LVM 标签在重新引导时具有持久性并在整个集群中可用。

LVM 标签可将该设备识别为 LVM 物理卷。它包含物理卷的随机唯一识别符(UUID)。它还以字节为单位保存块设备的大小,并记录 LVM 元数据存储在该设备中的位置。

LVM 元数据包含您系统中 LVM 卷组的配置详情。默认情况下,卷组中的每个物理卷的元数据区域都会保留一个一样的元数据副本。LVM 元数据很小,它以 ASCII 格式保存。

目前,LVM 允许您在每个物理卷中保存 0、1 或者 2 个元数据副本。默认为 1 个副本。当您在物理卷中配置元数据副本数后,您将无法再更改该号码。第一个副本保存在设备的起始位置,紧随在标签后面。如果有第二个副本,会将其放在设备的末尾。如果您不小心写入了不同于您想要写入的磁盘覆盖了磁盘起始部分,那么您可以使用在设备末尾的元数据的第二个副本恢复元数据。

1.2.1. LVM 物理卷布局

图 1.2 “物理卷布局” 显示 LVM 物理卷布局。LVM 标签在第二个扇区,接下来是元数据区域,后面是设备的可用空间。

在 Linux 内核中(以及整个此文档中),每个扇区的大小为 512K。

图 1.2. 物理卷布局

1.2.2. 一个磁盘上的多个分区

LVM 允许您在磁盘分区外创建物理卷。红帽建议您创建一个覆盖整个磁盘的单一分区,将其标记为 LVM 物理卷,理由如下:

方便管理

如果每个真实磁盘只出现一次,那么在系统中追踪硬件就比较容易。特别是当磁盘失败时。另外,单一磁盘中有多个物理卷可导致内核在引导时发出未知分区类型警告。

条带化性能

LVM 无法告知两个物理卷位于同一个物理磁盘中。如果您在两个物理卷位于同一物理磁盘时创建了条状逻辑卷,那么条带就可能在同一磁盘的不同分区中。这可能会降低性能,而不是提高性能。

虽然不建议您这样做,但在某些情况下可能需要将磁盘分成独立的 LVM 物理卷。例如:在有多个磁盘的系统中,当您要将现有系统迁移到 LVM 卷时,可能需要将数据在分区间转移。另外,如果您有一个很大的磁盘,并且因为管理的原因想要有一个以上卷组,那么对磁盘进行分区是很必要的。如果您的磁盘有一个以上的分区,且这些分区在同一卷组中,在创建条状卷时指定逻辑卷中应包含哪些分区。

1.3. 卷组

物理卷合并为卷组(VG)。这样就创建了一个磁盘空间池,可使用它分配逻辑卷。

在卷组中,可用于分配的磁盘空间被分成固定大小的单元,我们称之为扩展。一个扩展就是可被分配的最小空间单位。在物理卷中,扩展被称为物理扩展。

逻辑卷被分配成与物理卷扩展大小相同的逻辑扩展。因此卷组中的所有逻辑卷的扩展大小都是一样的。卷组将逻辑扩展与物理扩展匹配。

1.4. LVM 逻辑卷

在 LVM 中,卷组被分成逻辑卷。管理员可以在不损坏数据的情况下增大或缩小逻辑卷,这与标准磁盘分区不同。如果卷组中的物理卷位于不同的驱动器或者 RAID 阵列中,那么管理员也可以跨存储设备分配逻辑卷。

如果您缩小逻辑卷到比卷中数据所需的容量小的容量时,则可能会丢失数据。要确定最大的灵活性,请创建符合您当前需要的逻辑卷,并保留多余的存储容量未分配。您可以根据需要安全地扩展逻辑卷使用未分配空间。

在 AMD、Intel、ARM 和 IBM Power Systems 服务器中,引导装载程序无法读取 LVM 卷。您必须为您的 /boot 分区创建一个标准的非 LVM 磁盘分区。在 IBM Z 中,zipl 引导装载程序使用线性映射支持 LVM 逻辑卷中的 /boot。默认情况下,安装过程总是在 LVM 卷中创建 / 和 swap 分区,在物理卷中有一个独立的 /boot 分区。

下面的部分描述了不同类型的逻辑卷类型。

1.4.1. 线性卷

线性卷将来自一个或多个物理卷的空间集合到一个逻辑卷中。例如:如果您有两个 60GB 的磁盘,您可以创建一个 120GB 的逻辑卷。物理存储是连在一起的。

创建一个线性卷,按顺序为逻辑卷的区域分配物理扩展范围。例如:如 图 1.3 “扩展映射” 所示,逻辑扩展 1 到 99 可映射到一个物理卷,逻辑扩展 100 到 198 可映射到第二个物理卷。从应用程序的角度来看,它是一个大小为 198 个扩展的设备。

图 1.3. 扩展映射

构成逻辑卷的物理卷大小应该相同。图 1.4 “物理卷大小不同的线性卷” 显示卷组 VG1,其物理扩展大小为 4MB。这个卷组包括两个名为 PV1 和 PV2 的物理卷。物理卷被分成 4MB 单元,因为这是扩展的大小。在这个示例中,PV1 的大小为 200 个扩展(800MB),PV2 的大小为 100 个扩展(400MB)。您可以在 1 到 300 个扩展间创建线性卷(4MB 到 1200MB)。在这个示例中,名为 LV1 的线性卷的大小为 300 个扩展。

图 1.4. 物理卷大小不同的线性卷

您可以从物理扩展池中根据您需要的大小配置一个以上的线性逻辑卷。图 1.5 “多个逻辑卷” 显示相同的卷组如 图 1.4 “物理卷大小不同的线性卷”,但在这个示例中,有两个逻辑卷被从卷组中分离出来: LV1,大小为 250 个扩展(1000MB)和 LV2,大小为 50 个扩展(200MB)。

图 1.5. 多个逻辑卷

1.4.2. 条状逻辑卷

当您向 LVM 逻辑卷写入数据时,文件系统会在基本物理卷之间部署数据。您可以通过创建一个条状逻辑卷来控制将数据写入物理卷的方法。对于大量连续的读取和写入,这样可以提高数据输入/输出的效率。

条带化通过以 round-robin 模式向预定数目的物理卷写入数据来提高性能。使用条带,I/O 可以并行执行。在某些情况下,这样可以使条带中每个额外的物理卷获得接近线性的性能。

以下示例显示数据在三个物理卷之间进行条状分布。在这个图表中:

- 数据的第一条写入第一个物理卷

- 数据的第二条写入第二个物理卷

- 数据的第三条被写入第三个物理卷

- 数据的第四条写入第一个物理卷

在条状逻辑卷中,条的大小不能超过扩展的大小。

图 1.6. 在三个 PV 间对数据进行条状化

条状逻辑卷可通过在第一组设备的末尾连接另一组设备来扩展。要扩展条状逻辑卷,在基本物理卷集合中必须有足够的可用空间组成卷组来支持条带。例如:如果您有一个双向条带使用了整个卷组,那么向卷组中添加单一物理卷不会允许您扩展条带。反之,您必须在卷组中添加至少两个物理卷。

1.4.3. RAID 逻辑卷

LVM 支持 RAID 0、1、4、5、6 和 10。

LVM RAID 卷有以下特征:

- LVM 创建和管理的 RAID 逻辑卷利用多设备(MD)内核驱动程序。

- 您可以从阵列中临时分割 RAID1 镜像,并在之后将其合并到阵列中。

- LVM RAID 卷支持快照。

集群

RAID 逻辑卷不是集群感知型的。

您可以只在一台机器中创建和激活 RAID 逻辑卷,但不能在多台机器中同时激活它们。

子卷

当您创建 RAID 逻辑卷时,LVM 会为阵列中的每个数据或者奇偶校验子卷创建一个元数据子卷,它是一个扩展大小。

例如:创建一个双向 RAID1 阵列会导致两个元数据子卷(lv_rmeta_0 和 lv_rmeta_1)和两个数据子卷(lv_rimage_0 和 lv_rimage_1)。同样,创建三向条带(加 1 隐式奇偶校验设备)RAID4 会产生 4 个元数据子卷(lv_rmeta_0、lv_rmeta_1、lv_rmeta_2和 lv_rmeta_3)和 4 个数据子卷(lv_rimage_0、lv_rimage_1、lv_rimage_2和 lv_rimage_3)。

完整性

当 RAID 设备失败或者发生软崩溃时,可能会丢失数据。数据存储中的软崩溃意味着,从存储设备中检索的数据与写入到那个设备中的数据不同。在 RAID LV 中添加完整性有助于缓解或防止软崩溃。要了解更多有关软崩溃和如何在 RAID LV 中添加完整性的信息,请参阅 第 10.6 节 “使用带有 RAID LV 的 DM 完整性功能”。

1.4.4. 精简配置的逻辑卷(精简卷)

逻辑卷可以使用精简模式置备。这可让您创建大于可用扩展的逻辑卷。使用精简配置,您可以管理一个空闲空间的存储池,称为精简池,可在应用程序需要时将其分配给任意数量的设备。然后,当应用程序实际写入逻辑卷时,您可以创建可绑定到精简池的设备以便以后分配。可在需要时动态扩展精简池,以便有效分配存储空间。

不支持集群中跨节点的精简卷。精简池及其所有精简卷必须只在一个集群节点中单独激活。

通过使用精简配置,存储管理员可过量使用物理存储,从而避免购买额外的存储。例如:如果 10 个用户为每个应用程序请求一个 100GB 文件系统,存储管理员可以为每个用户创建一个 100GB 文件系统,但其后端的实际存储可以小于这个大小,它在需要时才使用实际的存储。在使用精简配置时,存储管理员务必要监控存储池,并在其被完全占用时添加更多容量。

要确定可以使用所有可用空间,LVM 支持数据丢弃功能。这允许重复使用丢弃文件或其他块范围使用的空间。

精简卷支持新的复制时写入(COW)快照逻辑卷部署,这将允许很多虚拟设备在精简池中共享相同数据。

1.4.5. 快照卷

LVM 快照功能提供在特定时间创建设备的虚拟映像且不会造成服务中断的功能。在提取快照后,当对原始设备进行修改时,快照功能会生成有变化的数据区域的副本,以便重建该设备的状态。

LVM 支持精简配置的快照。

因为快照只复制创建快照后修改的数据区域,快照功能需要的存储空间较小。例如,对于很少更新的原始卷,原始容量的 3-5% 就足以进行快照维护。

文件系统的快照副本是虚拟副本,不是文件系统的实际介质备份。快照不能替代备份。

预留用来存储原始卷更改的空间大小取决于快照的大小。例如:如果您要创建快照,且要完全覆盖原始卷,则快照必须至少与原始卷大小方可保存更改。您需要根据预期的更改程度调整快照大小。例如,一个多数用于读取卷的简短快照(如 /usr)的空间会比看到写入操作的卷的长时间快照要小,比如 /home。

如果快照已满,则快照就会变得无效,因为它无法跟踪原始卷中的更改。您应该定期监控快照的大小。快照可以完全重新定义大小,因此如果您有存储容量,则可以增大快照卷以避免丢失快照。另外,如果您发现快照卷超过您的需要,可以减小卷的大小来为其它逻辑卷最大限度腾出空间。

当您创建快照文件系统时,仍可对原始系统有完全的读和写访问。如果更改了快照中的块,则会标记那个块,永远不会从原始卷中复制该块。

快照有几个用途:

- 最典型的是。当您需要在逻辑卷中执行备份而不停止持续更新数据的 Live 系统时会提取快照。

-

您可以在快照文件系统中执行

fsck命令检查文件系统的完整性,并决定原始文件系统是否需要修复。 - 因为快照是可读/写的,您可以根据产品数据测试应用程序,方法是提取一个快照并根据快照运行测试,从而不会影响真实数据。

- 您可以为 Red Hat Virtualization 创建 LVM 卷。LVM 快照可用来创建虚拟客体镜像的快照。这些快照可方便修改现有客户虚拟机或者使用最小附加存储创建新客户虚拟机。

您可以使用 lvconvert 的 --merge 选项将快照合并到原始卷中。这个功能的一个作用是在您丢失数据或者文件或者需要将系统恢复到之前的状态时执行系统恢复。合并快照卷后,得到的逻辑卷将具有原始卷的名称、副号码和 UUID 并删除合并的快照。

1.4.6. 精简配置的快照卷

Red Hat Enterprise Linux 支持精简配置的快照卷。精简快照卷允许将很多虚拟设备保存在同一个数据卷中。这简化了管理过程,并允许在快照卷间共享数据。

除了所有 LVM 快照卷以及所有精简卷一样,集群的节点不支持精简快照卷。快照卷必须在一个集群节点中完全激活。

精简快照卷提供以下优点:

- 当有相同原始卷的多个快照时,精简快照卷就可以减少磁盘用量。

- 如果同一来源有多个快照,对原始卷的写入会导致 COW 操作保留数据。增加原始卷的快照数量应该不会造成很大的性能下降。

- 精简快照卷可用于另一个快照的逻辑卷来源。这将可以实现任意深度的递归快照(一个快照的快照的快照…)。

- 精简逻辑卷的快照也创建一个精简逻辑卷。这不需要数据空间,直到要求 COW 操作,或者直到快照本身写完。

- 精简快照卷不需要使用原始卷激活,因此当原始快照卷有很多不活跃时,用户可能只激活原始卷。

- 当您删除精简置备快照卷的原始卷时,该原始卷的每个快照都会变为独立的精简置备卷。这意味着,您不需要将快照与原始卷合并,而不必选择删除原始卷,然后使用该独立卷作为新快照的原始卷创建新置备快照。

虽然使用精简快照卷有很多优点,但在有些情况下,旧的 LVM 快照卷功能可能更适合您的需要:

- 您不能更改精简池的块大小。如果精简池的块大小较大(例如: 1MB),且您需要一个简短的快照,且大型的块大小不高,则可以选择使用旧的快照功能。

- 您不能限制精简快照卷的大小 ; 如果需要,快照将使用精简池中所有空间。这可能不适用于您的需要。

一般说来,在决定使用什么快照格式时,您应该考虑具体要求。

1.4.7. 缓存卷

LVM 支持在较慢的块设备中使用快速块设备(比如 SSD 驱动器)作为写入或者写入缓存。用户可创建缓存逻辑卷来提升其现有逻辑卷性能,或者创建一个由带有大型、慢速设备的小、快速设备组成的新的缓存逻辑卷。

第 2 章 使用 RHEL 系统角色管理本地存储

要使用 Ansible 管理 LVM 和本地文件系统(FS),您可以使用 storage 角色,该角色是 RHEL 8 中可用的 RHEL 系统角色之一。

使用 storage 角色可让您从 RHEL 7.7 开始自动管理多个机器中的磁盘和逻辑卷中的文件系统,并在 RHEL 7.7 的所有 RHEL 版本间自动管理文件系统。

有关 RHEL 系统角色以及如何应用它们的更多信息,请参阅 RHEL 系统角色简介。

2.1. 存储角色简介

storage 角色可以管理:

- 磁盘上未被分区的文件系统

- 完整的 LVM 卷组,包括其逻辑卷和文件系统

使用 storage 角色,您可以执行以下任务:

- 创建文件系统

- 删除文件系统

- 挂载文件系统

- 卸载文件系统

- 创建 LVM 卷组

- 删除 LVM 卷组

- 创建逻辑卷

- 删除逻辑卷

- 创建 RAID 卷

- 删除 RAID 卷

- 创建带有 RAID 的 LVM 池

- 删除带有 RAID 的 LVM 池

2.2. 在存储设备角色中识别存储设备的参数

您的 storage 角色配置只会影响您在以下变量中列出的文件系统、卷和池。

storage_volumes在所有要管理的未分区磁盘中的文件系统列表。

当前不支持的分区。

storage_pools要管理的池列表。

目前唯一支持的池类型是 LVM。对于 LVM,池代表卷组(VG)。每个池中都有一个要由角色管理的卷列表。对于 LVM,每个卷对应一个带文件系统的逻辑卷(LV)。

2.3. 在块设备中创建 XFS 文件系统的 Ansible playbook 示例

本节提供了一个 Ansible playbook 示例。此 playbook 应用 storage 角色,以使用默认参数在块设备中创建 XFS 文件系统。

storage 角色只能在未分区、整个磁盘或者逻辑卷(LV)中创建文件系统。它不能在分区中创建文件系统。

例 2.1. 在 /dev/sdb 上创建 XFS 的 playbook

---

- hosts: all

vars:

storage_volumes:

- name: barefs

type: disk

disks:

- sdb

fs_type: xfs

roles:

- rhel-system-roles.storage-

卷名称(示例中是

barefs)目前是任意卷。storage角色根据disks:属性中列出的磁盘设备识别卷。 -

您可以省略

fs_type: xfs行,因为 XFS 是 RHEL 8 中的默认文件系统。 要在 LV 中创建文件系统,在

disks:属性中提供 LVM 设置,包括保护卷组。详情请参阅 管理逻辑卷的 Ansible playbook 示例。不要提供到 LV 设备的路径。

其它资源

-

有关

storage系统角色中使用的参数的详情,请查看/usr/share/ansible/roles/rhel-system-roles.storage/README.md文件。

2.4. 永久挂载文件系统的 Ansible playbook 示例

本节提供了一个 Ansible playbook 示例。此 playbook 应用 storage 角色来立即和永久挂载 XFS 文件系统。

例 2.2. 在 /dev/sdb 上将文件系统挂载到 /mnt/data 的 playbook

---

- hosts: all

vars:

storage_volumes:

- name: barefs

type: disk

disks:

- sdb

fs_type: xfs

mount_point: /mnt/data

roles:

- rhel-system-roles.storage-

此 playbook 将文件系统添加到

/etc/fstab文件中,并立即挂载文件系统。 -

如果

/dev/sdb设备或挂载点目录中的文件系统不存在,则 playbook 会创建它们。

其它资源

-

有关

storage系统角色中使用的参数的详情,请查看/usr/share/ansible/roles/rhel-system-roles.storage/README.md文件。

2.5. 管理逻辑卷的 Ansible playbook 示例

本节提供了一个 Ansible playbook 示例。这个 playbook 应用 storage 角色在卷组中创建 LVM 逻辑卷。

例 2.3. 在 myvg 卷组中创建 mylv 逻辑卷的 playbook

- hosts: all

vars:

storage_pools:

- name: myvg

disks:

- sda

- sdb

- sdc

volumes:

- name: mylv

size: 2G

fs_type: ext4

mount_point: /mnt

roles:

- rhel-system-roles.storagemyvg卷组由以下磁盘组成:-

/dev/sda -

/dev/sdb -

/dev/sdc

-

-

如果

myvg卷组已存在,则 playbook 会将逻辑卷添加到卷组中。 -

如果

myvg卷组不存在,则 playbook 会创建它。 -

playbook 在

mylv逻辑卷中创建 Ext4 文件系统,并在其中永久挂载文件系统/mnt。

其它资源

-

有关

storage系统角色中使用的参数的详情,请查看/usr/share/ansible/roles/rhel-system-roles.storage/README.md文件。

2.6. 启用在线块丢弃的 Ansible playbook 示例

本节提供了一个 Ansible playbook 示例。此 playbook 应用 storage 角色来挂载启用了在线块丢弃的 XFS 文件系统。

例 2.4. 一个 playbook,它在 /mnt/data/ 上启用在线块丢弃功能

---

- hosts: all

vars:

storage_volumes:

- name: barefs

type: disk

disks:

- sdb

fs_type: xfs

mount_point: /mnt/data

mount_options: discard

roles:

- rhel-system-roles.storage其它资源

- 此 playbook 还执行持久挂载示例中描述的所有操作,如 Ansible playbook 所述永久挂载文件系统。

-

有关

storage系统角色中使用的参数的详情,请查看/usr/share/ansible/roles/rhel-system-roles.storage/README.md文件。

2.7. 创建和挂载 Ext4 文件系统的 Ansible playbook 示例

本节提供了一个 Ansible playbook 示例。此 playbook 应用 storage 角色来创建和挂载 Ext4 文件系统。

例 2.5. 在 /dev/sdb 上创建 Ext4 并挂载到 /mnt/data 的 playbook

---

- hosts: all

vars:

storage_volumes:

- name: barefs

type: disk

disks:

- sdb

fs_type: ext4

fs_label: label-name

mount_point: /mnt/data

roles:

- rhel-system-roles.storage-

playbook 在

/dev/sdb磁盘上创建文件系统。 -

playbook 会永久将文件系统挂载到

/mnt/data目录中。 -

文件系统的标签是

label-name。

其它资源

-

有关

storage系统角色中使用的参数的详情,请查看/usr/share/ansible/roles/rhel-system-roles.storage/README.md文件。

2.8. 创建和挂载 ext3 文件系统的 Ansible playbook 示例

本节提供了一个 Ansible playbook 示例。此 playbook 应用 storage 角色来创建和挂载 Ext3 文件系统。

例 2.6. 在 /dev/sdb 上创建 Ext3 并挂载到 /mnt/data 的 playbook

---

- hosts: all

vars:

storage_volumes:

- name: barefs

type: disk

disks:

- sdb

fs_type: ext3

fs_label: label-name

mount_point: /mnt/data

roles:

- rhel-system-roles.storage-

playbook 在

/dev/sdb磁盘上创建文件系统。 -

playbook 会永久将文件系统挂载到

/mnt/data目录中。 -

文件系统的标签是

label-name。

其它资源

-

有关

storage系统角色中使用的参数的详情,请查看/usr/share/ansible/roles/rhel-system-roles.storage/README.md文件。

2.9. 使用存储系统角色配置 RAID 卷

使用 storage 系统角色,您可以使用 Red Hat Ansible Automation Platform 在 RHEL 上配置 RAID 卷。在本小节中,您将了解如何使用可用参数设置 Ansible playbook,以配置 RAID 卷以满足您的要求。

先决条件

您已在要运行 playbook 的系统中安装了 Red Hat Ansible Engine。

注意您不必在要部署

storage解决方案的系统中安装 Red Hat Ansible Automation Platform。-

已安装该系统中要运行 playbook 的

rhel-system-roles软件包。 -

您有一个清单文件详细描述了您要使用

storage系统角色部署 RAID 卷的系统。

流程

使用以下内容

playbook.yml创建新文件:- hosts: all vars: storage_safe_mode: false storage_volumes: - name: data type: raid disks: [sdd, sde, sdf, sdg] raid_level: raid0 raid_chunk_size: 32 KiB mount_point: /mnt/data state: present roles: - name: rhel-system-roles.storage警告设备名称在某些情况下可能会改变,例如:当您在系统中添加新磁盘时。因此,为了避免数据丢失,我们不建议在 playbook 中使用特定的磁盘名称。

可选。验证 playbook 语法。

# ansible-playbook --syntax-check playbook.yml在清单文件上运行 playbook:

# ansible-playbook -i inventory.file /path/to/file/playbook.yml

其它资源

- 有关 RAID 的详情,请参阅管理 RAID。

-

有关存储系统角色中使用的参数的详情,请查看

/usr/share/ansible/roles/rhel-system-roles.storage/README.md文件。

2.10. 使用存储系统角色使用 RAID 配置 LVM 池

通过 storage 系统角色,您可以使用 Red Hat Ansible Automation Platform 在 RHEL 上使用 RAID 配置 LVM 池。在本小节中,您将了解如何使用可用参数设置 Ansible playbook,以配置使用 RAID 的 LVM 池。

先决条件

您已在要运行 playbook 的系统中安装了 Red Hat Ansible Engine。

注意您不必在要部署

storage解决方案的系统中安装 Red Hat Ansible Automation Platform。-

已安装该系统中要运行 playbook 的

rhel-system-roles软件包。 -

您有一个清单文件详细描述了您要使用

storage系统角色使用 RAID 配置具有 RAID 的系统。

流程

使用以下内容

playbook.yml创建新文件:- hosts: all vars: storage_safe_mode: false storage_pools: - name: my_pool type: lvm disks: [sdh, sdi] raid_level: raid1 volumes: - name: my_pool size: "1 GiB" mount_point: "/mnt/app/shared" fs_type: xfs state: present roles: - name: rhel-system-roles.storage注意要使用具有 RAID 的 LVM 池,您必须使用

raid_level参数指定 RAID 类型。可选。验证 playbook 语法。

# ansible-playbook --syntax-check playbook.yml在清单文件上运行 playbook:

# ansible-playbook -i inventory.file /path/to/file/playbook.yml

其它资源

- 有关 RAID 的详情,请参阅管理 RAID。

-

有关存储系统角色中使用的参数的详情,请查看

/usr/share/ansible/roles/rhel-system-roles.storage/README.md文件。

2.11. 使用存储角色创建 LUKS 加密卷

您可以通过运行 Ansible playbook,使用 storage 角色创建并配置使用 LUKS 加密的卷。

先决条件

您已在要运行 playbook 的系统中安装了 Red Hat Ansible Engine。

注意您不必在要创建卷的系统中安装 Red Hat Ansible Automation Platform。

-

您已在 Ansible 控制器上安装了

rhel-system-roles软件包。 - 您有一个清单文件详细描述了您要使用存储系统角色部署 LUKS 加密卷的系统。

流程

使用以下内容

playbook.yml创建新文件:- hosts: all vars: storage_volumes: - name: barefs type: disk disks: - sdb fs_type: xfs fs_label: label-name mount_point: /mnt/data encryption: true encryption_password: your-password roles: - rhel-system-roles.storage可选。验证 playbook 语法:

# ansible-playbook --syntax-check playbook.yml在清单文件上运行 playbook:

# ansible-playbook -i inventory.file /path/to/file/playbook.yml

其它资源

- 如需了解更多与 LUKS 相关的信息,请参阅 17。使用 LUKS 加密块设备。

-

有关

storage系统角色中使用的参数的详情,请查看/usr/share/ansible/roles/rhel-system-roles.storage/README.md文件。

其它资源

如需更多信息,请安装

rhel-system-roles软件包并查看以下目录:-

/usr/share/doc/rhel-system-roles/storage/ -

/usr/share/ansible/roles/rhel-system-roles.storage/

-

第 3 章 部署 LVM

下面的步骤代表了全新安装的操作系统中 LVM 逻辑卷的基本配置。

3.1. 创建 LVM 物理卷

这个步骤描述了如何创建和标记 LVM 物理卷(PV)。

先决条件

-

已安装

lvm2软件包。

流程

要创建多个物理卷,在

pvcreate命令中使用以空格分隔的设备名称作为参数:# pvcreate /dev/vdb1 /dev/vdb2

这会在 /dev/vdb1 和 /dev/vdb2 中加一个标签,将其标记为属于 LVM 的物理卷。

详情请查看

pvcreateman page。

3.2. 创建 LVM 卷组

这个步骤描述了如何创建 LVM 卷组(VG)。

先决条件

-

已安装

lvm2软件包。 - 创建一个或多个物理卷。请参阅如何在其中操作的指令 第 3.1 节 “创建 LVM 物理卷”。

流程

要创建卷组,请使用以下命令:

# vgcreate myvg /dev/vdb1 /dev/vdb2

这将创建一个名为 myvg 的 VG。PV /dev/vdb1 和 /dev/vdb2 是 VG myvg 的基本存储级别。

详情请查看

vgcreateman page。

之后可以使用 PV 扩展上述 VG。要扩展 VG,请使用以下命令:

# vgextend myvg /dev/vdb3

3.3. 创建 LVM 逻辑卷

这个步骤描述了如何创建 LVM 逻辑卷(LV)。

先决条件

-

已安装

lvm2软件包。 - 已创建卷组。请参阅如何在其中操作的指令 第 3.2 节 “创建 LVM 卷组”。

流程

要创建逻辑卷,请使用以下命令:

# lvcreate -n lv01 -L 500M myvg

-n选项允许用户将 LV 名称设置为 lv01。-L选项允许用户在本示例中以 Mb 单位设定 LV 的大小,但可以使用其它单元。默认情况下 LV 类型是线性的,但用户可使用--type选项指定所需类型。重要如果 VG 没有足够数量的可用物理扩展用于请求的大小和类型,该命令将失败。

详情请查看

lvcreateman page。

第 4 章 配置 LVM 逻辑卷

以下步骤提供基本 LVM 管理任务示例。

4.1. 使用 CLI 命令

以下小节描述了 LVM CLI 命令的一些一般操作功能。

在命令行参数中指定单元

当在命令行参数中需要大小时,可以明确指定其单位。如果您没有指定单位,那么就使用默认单位,通常为 KB 或者 MB。LVM CLI 命令不接受分数。

当在命令行参数中指定单位时,LVM 是不区分大小写的, M 和 m 是相同的,例如,都代表单位是 1024。但是,当在命令中指定 --units 参数时,小写表示该单位是 1024,而大写表示该单位是 1000。

指定卷组和逻辑卷

在 LVM CLI 命令中指定卷组或者逻辑卷时请注意以下几点。

-

如果命令使用卷组或者逻辑卷名称作为参数,则完整路径名称是可选的。在名为

vg0卷组中的一个名为lvol0的逻辑卷可以被指定为vg0/lvol0。 - 当需要卷组列表但为空时,则使用所有卷组的列表替代。

-

当需要列出逻辑卷但提供了一个卷组,则使用在那个卷组中的所有逻辑卷列表替代。例如:

lvdisplay vg0命令将显示卷组vg0中的所有逻辑卷。

增加输出详细程度

所有 LVM 命令都接受 -v 参数,该参数可多次输入来提高输出的详细程度。以下示例显示了 lvcreate 命令的默认输出。

# lvcreate -L 50MB new_vg

Rounding up size to full physical extent 52.00 MB

Logical volume "lvol0" created

以下命令显示带有 -v 参数的 lvcreate 命令的输出结果。

# lvcreate -v -L 50MB new_vg

Rounding up size to full physical extent 52.00 MB

Archiving volume group "new_vg" metadata (seqno 1).

Creating logical volume lvol0

Creating volume group backup "/etc/lvm/backup/new_vg" (seqno 2).

Activating logical volume new_vg/lvol0.

activation/volume_list configuration setting not defined: Checking only host tags for new_vg/lvol0.

Creating new_vg-lvol0

Loading table for new_vg-lvol0 (253:0).

Resuming new_vg-lvol0 (253:0).

Wiping known signatures on logical volume "new_vg/lvol0"

Initializing 4.00 KiB of logical volume "new_vg/lvol0" with value 0.

Logical volume "lvol0" created

-vv、-vvv 和 -vvvv 参数显示命令执行的详情。-vvvv 参数提供最大的信息量。以下示例显示了 lvcreate 命令的输出行前几行(指定了 -vvvv 参数)。

# lvcreate -vvvv -L 50MB new_vg

#lvmcmdline.c:913 Processing: lvcreate -vvvv -L 50MB new_vg

#lvmcmdline.c:916 O_DIRECT will be used

#config/config.c:864 Setting global/locking_type to 1

#locking/locking.c:138 File-based locking selected.

#config/config.c:841 Setting global/locking_dir to /var/lock/lvm

#activate/activate.c:358 Getting target version for linear

#ioctl/libdm-iface.c:1569 dm version OF [16384]

#ioctl/libdm-iface.c:1569 dm versions OF [16384]

#activate/activate.c:358 Getting target version for striped

#ioctl/libdm-iface.c:1569 dm versions OF [16384]

#config/config.c:864 Setting activation/mirror_region_size to 512

...显示 LVM CLI 命令的帮助信息

您可以使用命令的 --help 参数显示任意 LVM CLI 命令的帮助信息。

# commandname --help

要显示某个命令的 man page,请执行 man 命令:

# man commandname

man lvm 命令提供有关 LVM 的常规在线信息。

4.2. 在三个磁盘中创建 LVM 逻辑卷

这个示例步骤创建一个名为 mylv 的 LVM 逻辑卷,它由磁盘 /dev/sda1、/dev/sdb1 和 /dev/sdc1 组成。

要在卷组中使用磁盘,请使用

pvcreate命令将其标记为 LVM 物理卷。警告这个命令会破坏

/dev/sda1、/dev/sdb1和/dev/sdc1中的所有数据。#

pvcreate /dev/sda1 /dev/sdb1 /dev/sdc1Physical volume "/dev/sda1" successfully created Physical volume "/dev/sdb1" successfully created Physical volume "/dev/sdc1" successfully created创建由您创建的 LVM 物理卷组成的卷组。下面的命令创建了卷组

myvg。#

vgcreate myvg /dev/sda1 /dev/sdb1 /dev/sdc1Volume group "myvg" successfully created您可以使用

vgs命令显示新卷组的属性。#

vgsVG #PV #LV #SN Attr VSize VFree myvg 3 0 0 wz--n- 51.45G 51.45G从您创建的卷组中创建逻辑卷。下面的命令在卷组

mylv中创建逻辑卷myvg。这个示例创建的逻辑卷,它使用了卷组的 2GB。#

lvcreate -L 2G -n mylv myvgLogical volume "mylv" created在逻辑卷中创建文件系统。下面的命令在逻辑卷中创建了一个

ext4文件系统。#

mkfs.ext4 /dev/myvg/mylvmke2fs 1.44.3 (10-July-2018) Creating filesystem with 524288 4k blocks and 131072 inodes Filesystem UUID: 616da032-8a48-4cd7-8705-bd94b7a1c8c4 Superblock backups stored on blocks: 32768, 98304, 163840, 229376, 294912 Allocating group tables: done Writing inode tables: done Creating journal (16384 blocks): done Writing superblocks and filesystem accounting information: done下面的命令挂载逻辑卷并报告文件系统磁盘空间用量。

#

mount /dev/myvg/mylv /mnt#dfFilesystem 1K-blocks Used Available Use% Mounted on /dev/mapper/myvg-mylv 1998672 6144 1871288 1% /mnt

4.3. 创建 RAID0(条状)逻辑卷

RAID0 逻辑卷以条的大小为单位,将逻辑卷数据分散到多个数据子卷中。

创建 RAID0 卷的命令格式如下。

lvcreate --type raid0[_meta] --stripes Stripes --stripesize StripeSize VolumeGroup [PhysicalVolumePath ...]

表 4.1. RAID0 命令创建参数

| 参数 | 描述 |

|---|---|

|

|

指定 |

|

| 指定在其中分割逻辑卷的设备数。 |

|

| 以 KB 为单位指定每个条的大小。这是在移动到下一个设备前写入一个设备的数据量。 |

|

| 指定要使用的卷组。 |

|

| 指定要使用的设备。如果没有指定,LVM 会选择 Stripes 选项指定的设备数,每个条带一个。 |

这个示例步骤创建名为 mylv 的 LVM RAID0 逻辑卷,可在磁盘 /dev/sda1、/dev/sdb1 和 /dev/sdc1 跨磁盘条状分布数据。

使用

pvcreate命令将卷组中您要使用的磁盘标记为 LVM 物理卷。警告这个命令会破坏

/dev/sda1、/dev/sdb1和/dev/sdc1中的所有数据。#

pvcreate /dev/sda1 /dev/sdb1 /dev/sdc1Physical volume "/dev/sda1" successfully created Physical volume "/dev/sdb1" successfully created Physical volume "/dev/sdc1" successfully created创建卷组

myvg。下面的命令创建了卷组myvg。#

vgcreate myvg /dev/sda1 /dev/sdb1 /dev/sdc1Volume group "myvg" successfully created您可以使用

vgs命令显示新卷组的属性。#

vgsVG #PV #LV #SN Attr VSize VFree myvg 3 0 0 wz--n- 51.45G 51.45G从您创建的卷组中创建 RAID0 逻辑卷。以下命令从卷组

mylv中创建 RAID0 卷myvg。这个示例创建的逻辑卷大小为 2GB,有三个条带,条带的大小为 4KB。#

lvcreate --type raid0 -L 2G --stripes 3 --stripesize 4 -n mylv myvgRounding size 2.00 GiB (512 extents) up to stripe boundary size 2.00 GiB(513 extents). Logical volume "mylv" created.在 RAID0 逻辑卷中创建文件系统。下面的命令在逻辑卷中创建了一个

ext4文件系统。#

mkfs.ext4 /dev/myvg/mylvmke2fs 1.44.3 (10-July-2018) Creating filesystem with 525312 4k blocks and 131376 inodes Filesystem UUID: 9d4c0704-6028-450a-8b0a-8875358c0511 Superblock backups stored on blocks: 32768, 98304, 163840, 229376, 294912 Allocating group tables: done Writing inode tables: done Creating journal (16384 blocks): done Writing superblocks and filesystem accounting information: done下面的命令挂载逻辑卷并报告文件系统磁盘空间用量。

#

mount /dev/myvg/mylv /mnt#dfFilesystem 1K-blocks Used Available Use% Mounted on /dev/mapper/myvg-mylv 2002684 6168 1875072 1% /mnt

4.4. 重命名 LVM 逻辑卷

这个过程使用命令行 LVM 接口重新命名现有逻辑卷。

流程

- 如果逻辑卷当前已被挂载,卸载该卷。

如果在集群环境中存在逻辑卷,在其激活的所有节点上取消激活逻辑卷。对每个这样的节点运行以下命令:

[root@node-n]# lvchange --activate n vg-name/lv-name

使用

lvrename程序重新命名现有逻辑卷:# lvrename vg-name original-lv-name new-lv-name

另外,您还可以指定到该设备的完整路径:

# lvrename /dev/vg-name/original-lv-name /dev/vg-name/new-lv-name

其它资源

-

lvrename(8)man page

4.5. 从逻辑卷中删除磁盘

这些示例步骤演示了如何从现有逻辑卷中删除磁盘,可以替换磁盘,也可以使用磁盘作为不同卷的一部分。要删除磁盘,您必须首先将 LVM 物理卷中的扩展移动到不同的磁盘或者一组磁盘中。

4.5.1. 将扩展移动到现有物理卷中

在这个示例中,逻辑卷是在卷组 myvg 的四个物理卷中进行分配的。

# pvs -o+pv_used

PV VG Fmt Attr PSize PFree Used

/dev/sda1 myvg lvm2 a- 17.15G 12.15G 5.00G

/dev/sdb1 myvg lvm2 a- 17.15G 12.15G 5.00G

/dev/sdc1 myvg lvm2 a- 17.15G 12.15G 5.00G

/dev/sdd1 myvg lvm2 a- 17.15G 2.15G 15.00G

这个示例将扩展从 /dev/sdb1 中移出,以便将其从卷组中删除。

如果在该卷组的其它物理卷中没有足够的可用扩展,您可以在想要删除的设备中执行

pvmove命令,且没有其他选项,那么扩展就会被分配到其它设备中。在集群中,

pvmove命令只能移动只在单一节点中活跃的逻辑卷。#

pvmove /dev/sdb1/dev/sdb1: Moved: 2.0% ... /dev/sdb1: Moved: 79.2% ... /dev/sdb1: Moved: 100.0%在

pvmove命令执行完毕后,扩展的分配如下:#

pvs -o+pv_usedPV VG Fmt Attr PSize PFree Used /dev/sda1 myvg lvm2 a- 17.15G 7.15G 10.00G /dev/sdb1 myvg lvm2 a- 17.15G 17.15G 0 /dev/sdc1 myvg lvm2 a- 17.15G 12.15G 5.00G /dev/sdd1 myvg lvm2 a- 17.15G 2.15G 15.00G使用

vgreduce命令从卷组中删除物理卷/dev/sdb1。#

vgreduce myvg /dev/sdb1Removed "/dev/sdb1" from volume group "myvg" # pvs PV VG Fmt Attr PSize PFree /dev/sda1 myvg lvm2 a- 17.15G 7.15G /dev/sdb1 lvm2 -- 17.15G 17.15G /dev/sdc1 myvg lvm2 a- 17.15G 12.15G /dev/sdd1 myvg lvm2 a- 17.15G 2.15G

该磁盘现在可以物理删除或者分配给其他用户。

4.5.2. 将扩展移动到新磁盘中

在这个示例中,逻辑卷在卷组 myvg 中的三个物理卷中进行分配,如下所示:

# pvs -o+pv_used

PV VG Fmt Attr PSize PFree Used

/dev/sda1 myvg lvm2 a- 17.15G 7.15G 10.00G

/dev/sdb1 myvg lvm2 a- 17.15G 15.15G 2.00G

/dev/sdc1 myvg lvm2 a- 17.15G 15.15G 2.00G

这个示例步骤将 /dev/sdb1 的扩展移动到新设备 /dev/sdd1。

在

/dev/sdd1创建新物理卷。#

pvcreate /dev/sdd1Physical volume "/dev/sdd1" successfully created在现有卷组

myvg中添加新的物理卷/dev/sdd1。#

vgextend myvg /dev/sdd1Volume group "myvg" successfully extended #pvs -o+pv_usedPV VG Fmt Attr PSize PFree Used /dev/sda1 myvg lvm2 a- 17.15G 7.15G 10.00G /dev/sdb1 myvg lvm2 a- 17.15G 15.15G 2.00G /dev/sdc1 myvg lvm2 a- 17.15G 15.15G 2.00G /dev/sdd1 myvg lvm2 a- 17.15G 17.15G 0使用

pvmove命令将数据从/dev/sdb1移至/dev/sdd1。#

pvmove /dev/sdb1 /dev/sdd1/dev/sdb1: Moved: 10.0% ... /dev/sdb1: Moved: 79.7% ... /dev/sdb1: Moved: 100.0% #pvs -o+pv_usedPV VG Fmt Attr PSize PFree Used /dev/sda1 myvg lvm2 a- 17.15G 7.15G 10.00G /dev/sdb1 myvg lvm2 a- 17.15G 17.15G 0 /dev/sdc1 myvg lvm2 a- 17.15G 15.15G 2.00G /dev/sdd1 myvg lvm2 a- 17.15G 15.15G 2.00G当您将数据移出

/dev/sdb1后,可以将其从卷组中删除。#

vgreduce myvg /dev/sdb1Removed "/dev/sdb1" from volume group "myvg"

现在您可以将磁盘重新分配给另一个卷组,或者将其从系统中删除。

4.6. 配置持久的设备号码

在载入模块的时候会自动分配主设备号码和副设备号码。如果总是使用相同的设备(主和副)号码激活块设备,有些应用程序效果最好。您可以使用以下参数通过 lvcreate 和 lvchange 命令来指定这些参数:

--persistent y --major major --minor minor

使用大的副号码以确定还没有动态分配给另一个设备。

如果要使用 NFS 导出一个文件系统,在 exports 文件中指定 fsid 参数可能会不需要在 LVM 中设定持久的设备号码。

4.7. 指定 LVM 扩展大小

当使用物理卷创建卷组时,默认情况下它的磁盘空间被分成 4MB 扩展。这个扩展是增大或者减小逻辑卷容量的最小值。大量的扩展不会影响逻辑卷的 I/O 性能。

如果默认扩展大小不合适,您可以使用 vgcreate 命令的 -s 选项指定扩展大小。您可以使用 vgcreate 命令的 -p 和 -l 参数限制卷组的物理或者逻辑卷数量。

4.8. 使用 RHEL 系统角色管理 LVM 逻辑卷

本节论述了如何应用 storage 角色来执行以下任务:

- 在由多个磁盘组成的卷组中创建 LVM 逻辑卷。

- 在逻辑卷中创建一个带给定标签的 ext4 文件系统。

- 永久挂载 ext4 文件系统。

先决条件

-

包括

storage角色的 Ansible playbook

如需有关如何应用 Ansible playbook 的信息,请参阅 应用角色。

4.8.1. 管理逻辑卷的 Ansible playbook 示例

本节提供了一个 Ansible playbook 示例。这个 playbook 应用 storage 角色在卷组中创建 LVM 逻辑卷。

例 4.1. 在 myvg 卷组中创建 mylv 逻辑卷的 playbook

- hosts: all

vars:

storage_pools:

- name: myvg

disks:

- sda

- sdb

- sdc

volumes:

- name: mylv

size: 2G

fs_type: ext4

mount_point: /mnt

roles:

- rhel-system-roles.storagemyvg卷组由以下磁盘组成:-

/dev/sda -

/dev/sdb -

/dev/sdc

-

-

如果

myvg卷组已存在,则 playbook 会将逻辑卷添加到卷组中。 -

如果

myvg卷组不存在,则 playbook 会创建它。 -

playbook 在

mylv逻辑卷中创建 Ext4 文件系统,并在其中永久挂载文件系统/mnt。

其它资源

-

有关

storage系统角色中使用的参数的详情,请查看/usr/share/ansible/roles/rhel-system-roles.storage/README.md文件。

4.8.2. 其它资源

-

有关

storage角色的更多信息,请参阅使用 RHEL 系统角色管理本地存储。

4.9. 删除 LVM 逻辑卷

这个过程使用命令行 LVM 接口删除现有逻辑卷。

下面的命令可从卷组 /dev/vg-name/lv-name 中删除逻辑卷 vg-name。

流程

- 如果逻辑卷当前已被挂载,卸载该卷。

如果在集群环境中存在逻辑卷,则在所有其激活的节点上取消激活逻辑卷。对每个这样的节点运行以下命令:

[root@node-n]# lvchange --activate n vg-name/lv-name

使用

lvremove实用程序删除逻辑卷:# lvremove /dev/vg-name/lv-name Do you really want to remove active logical volume "lv-name"? [y/n]: y Logical volume "lv-name" successfully removed

注意在这种情况下,逻辑卷还没有被取消激活。如果您在删除逻辑卷前明确取消激活了逻辑卷,则无法看到验证您是否要删除活跃逻辑卷的提示信息。

其它资源

-

lvremove(8)man page

第 5 章 修改逻辑卷的大小

创建逻辑卷后,您可以修改卷的大小。

5.1. 增大逻辑卷

要增大逻辑卷的大小,使用 lvextend 命令。

当扩展逻辑卷时,可以指定您想要增大的量,或者指定扩展它需要达到的大小。

下面的命令将逻辑卷 /dev/myvg/homevol 扩展到 12GB。

# lvextend -L12G /dev/myvg/homevol

lvextend -- extending logical volume "/dev/myvg/homevol" to 12 GB

lvextend -- doing automatic backup of volume group "myvg"

lvextend -- logical volume "/dev/myvg/homevol" successfully extended

下面的命令在逻辑卷 /dev/myvg/homevol 中添加了 1 GB。

# lvextend -L+1G /dev/myvg/homevol

lvextend -- extending logical volume "/dev/myvg/homevol" to 13 GB

lvextend -- doing automatic backup of volume group "myvg"

lvextend -- logical volume "/dev/myvg/homevol" successfully extended

在 lvcreate 命令中,可以使用 lvextend 命令的 -l 参数指定扩展数,从而增加逻辑卷的大小。您还可以使用此参数指定卷组的比例或者卷组中剩余空间的比例。下面的命令扩展了名为 testlv 的逻辑卷,使其使用卷组 myvg 的所有未分配的空间。

# lvextend -l +100%FREE /dev/myvg/testlv

Extending logical volume testlv to 68.59 GB

Logical volume testlv successfully resized当扩展逻辑卷后,有必要增大文件系统的大小以匹配文件系统。

默认情况下,大多数重新定义文件系统大小的工具都会将文件系统的大小增加到基本逻辑卷的大小,这样您就不必考虑为两个命令指定相同的容量。

5.2. 在逻辑卷中增大文件系统

要在逻辑卷中增大文件系统,执行以下步骤:

确定现有卷组中是否有足够的未分配空间来扩展逻辑卷。如果没有,执行以下步骤:

-

使用

pvcreate命令创建新物理卷。 -

使用

vgextend命令扩展包含您想要增大的文件系统逻辑卷的卷组,使其包含新的物理卷。

-

使用

-

一旦卷组足够大可包含更大的文件系统,使用

lvresize命令扩展逻辑卷。 - 在逻辑卷中重新定义文件系统大小。

请注意,您可以使用 lvresize 命令的 -r 选项扩展逻辑卷并使用单一命令重新定义基础文件系统大小

5.3. 缩小逻辑卷

您可以使用 lvreduce 命令减少逻辑卷的大小。

GFS2 或者 XFS 文件系统不支持缩小,因此您无法缩小包含 GFS2 或者 XFS 文件系统的逻辑卷大小。

如果您要缩小的逻辑卷包含一个文件系统,为了防止数据丢失,必须确定该文件系统没有使用将被缩小的逻辑卷中的空间。因此,建议您在逻辑卷包含文件系统时使用 lvreduce 命令的 --resizefs 选项。当您使用这个选项时,lvreduce 命令会在缩小逻辑卷前尝试缩小文件系统。如果缩小文件系统失败,比如文件系统已满或者文件系统不支持缩小,那么 lvreduce 命令将失败,也不会尝试缩小逻辑卷。

在大多数情况下,lvreduce 命令会警告可能的数据丢失,并要求用户进行确认。但是,您不应该依赖于这些确认提示来防止数据丢失,因为在某些情况下,您不会看到这些提示信息,比如当逻辑卷不活跃或者没有使用 --resizefs 选项时。

请注意:使用 lvreduce 命令的 --test 选项并不代表要执行的操作是安全的,因为这个选项不会检查文件系统或者测试文件系统大小。

下面的命令将卷组 vg00 中的逻辑卷lvol1 缩小到 64MB。在这个示例中,lvol1 包含一个文件系统,该命令可将其重新定义逻辑卷的大小。这个示例显示了该命令的输出结果。

# lvreduce --resizefs -L 64M vg00/lvol1

fsck from util-linux 2.23.2

/dev/mapper/vg00-lvol1: clean, 11/25688 files, 8896/102400 blocks

resize2fs 1.42.9 (28-Dec-2013)

Resizing the filesystem on /dev/mapper/vg00-lvol1 to 65536 (1k) blocks.

The filesystem on /dev/mapper/vg00-lvol1 is now 65536 blocks long.

Size of logical volume vg00/lvol1 changed from 100.00 MiB (25 extents) to 64.00 MiB (16 extents).

Logical volume vg00/lvol1 successfully resized.在调整大小值的前面使用 - 表示该值会从逻辑卷的实际大小中减小。下面的例子显示,您希望将逻辑卷缩小到 64MB,而不是对该卷缩小 64MB。

# lvreduce --resizefs -L -64M vg00/lvol15.4. 扩展条状逻辑卷

要增加条状逻辑卷的大小,基本物理卷中必须有足够的可用空间,以便让卷组支持条带。例如:如果您有一个使用了整个卷组的双向条带,那么向卷组中添加单一物理卷不会允许您扩展条带。反之,您必须在卷组中添加至少两个物理卷。

例如:考虑卷组 vg 包括两个基本物理卷,如下 vgs 命令所示。

# vgs

VG #PV #LV #SN Attr VSize VFree

vg 2 0 0 wz--n- 271.31G 271.31G您可以使用整个卷组空间创建一个条带。

#lvcreate -n stripe1 -L 271.31G -i 2 vgUsing default stripesize 64.00 KB Rounding up size to full physical extent 271.31 GB Logical volume "stripe1" created #lvs -a -o +devicesLV VG Attr LSize Origin Snap% Move Log Copy% Devices stripe1 vg -wi-a- 271.31G /dev/sda1(0),/dev/sdb1(0)

请注意:卷组现在没有剩余空间。

# vgs

VG #PV #LV #SN Attr VSize VFree

vg 2 1 0 wz--n- 271.31G 0下面的命令在卷组中添加了另一个物理卷,它提供了 135GB 的额外空间。

#vgextend vg /dev/sdc1Volume group "vg" successfully extended #vgsVG #PV #LV #SN Attr VSize VFree vg 3 1 0 wz--n- 406.97G 135.66G

此时您不能将条状逻辑卷扩展到卷组的大小,因为需要两个基本设备才可以对数据进行条带处理。

# lvextend vg/stripe1 -L 406G

Using stripesize of last segment 64.00 KB

Extending logical volume stripe1 to 406.00 GB

Insufficient suitable allocatable extents for logical volume stripe1: 34480

more required要扩展条状逻辑卷,添加另一个物理卷,然后扩展逻辑卷。在这个示例中,在卷组中添加两个物理卷,我们可将逻辑卷扩展成卷组的大小。

#vgextend vg /dev/sdd1Volume group "vg" successfully extended #vgsVG #PV #LV #SN Attr VSize VFree vg 4 1 0 wz--n- 542.62G 271.31G #lvextend vg/stripe1 -L 542GUsing stripesize of last segment 64.00 KB Extending logical volume stripe1 to 542.00 GB Logical volume stripe1 successfully resized

如果没有足够的基本物理设备来扩展条状逻辑卷,那么在扩展不是条带状的情况下也可能扩大卷,但可能导致性能下降。当在逻辑卷中添加空间时,默认操作是使用与现有逻辑卷最新片段相同的条状参数,但您可以覆盖这些参数。下面的例子在初始 lvextend 命令失败后,扩展了现有条状逻辑卷使用剩余空间。

#lvextend vg/stripe1 -L 406GUsing stripesize of last segment 64.00 KB Extending logical volume stripe1 to 406.00 GB Insufficient suitable allocatable extents for logical volume stripe1: 34480 more required #lvextend -i1 -l+100%FREE vg/stripe1

第 6 章 管理 LVM 卷组

这部分论述了管理卷组不同方面的命令。

6.1. 卷组

物理卷合并为卷组(VG)。这样就创建了一个磁盘空间池,可使用它分配逻辑卷。

在卷组中,可用于分配的磁盘空间被分成固定大小的单元,我们称之为扩展。一个扩展就是可被分配的最小空间单位。在物理卷中,扩展被称为物理扩展。

逻辑卷被分配成与物理卷扩展大小相同的逻辑扩展。因此卷组中的所有逻辑卷的扩展大小都是一样的。卷组将逻辑扩展与物理扩展匹配。

6.2. 显示卷组

您可以使用两个命令来显示 LVM 卷组的属性: vgs 和 vgdisplay。vgscan 命令为卷组扫描系统中所有支持的 LVM 块设备,也可以用来显示现有卷组。

vgs 命令提供了可以对其进行格式配置的卷组信息,每行显示一个卷组。vgs 命令提供大量格式控制,对脚本很有用。

vgdisplay 命令以固定格式显示卷组属性(比如大小、扩展、物理卷数目等等)。下面的例子显示了 vgdisplay 命令输出卷组 new_vg 的信息。如果您没有指定卷组,则会显示所有现有的卷组。

# vgdisplay new_vg

--- Volume group ---

VG Name new_vg

System ID

Format lvm2

Metadata Areas 3

Metadata Sequence No 11

VG Access read/write

VG Status resizable

MAX LV 0

Cur LV 1

Open LV 0

Max PV 0

Cur PV 3

Act PV 3

VG Size 51.42 GB

PE Size 4.00 MB

Total PE 13164

Alloc PE / Size 13 / 52.00 MB

Free PE / Size 13151 / 51.37 GB

VG UUID jxQJ0a-ZKk0-OpMO-0118-nlwO-wwqd-fD5D32

以下示例显示了 vgscan 命令的输出结果。

# vgscan

Reading all physical volumes. This may take a while...

Found volume group "new_vg" using metadata type lvm2

Found volume group "officevg" using metadata type lvm26.3. 合并卷组

要将两个卷组合并成一个卷组,使用 vgmerge 命令。如果这两个卷的物理扩展大小相等,且两个卷组的物理卷和逻辑卷的描述符合目的卷组的限制,您可以将一个不活跃的"源"卷与一个活跃或者不活跃的"目标"卷合并。

以下命令将不活跃卷组 my_vg 合并到活跃或者不活跃卷组 databases 中,并输出详细的运行时信息。

# vgmerge -v databases my_vg6.4. 分割卷组

在这个示例中,有一个由三个物理卷组成的卷组。如果在物理卷中有足够的空闲空间,就可在不添加新磁盘的情况下创建新的卷组。

在初始设置中,逻辑卷 mylv 是从卷组 myvg 中分离出来的,它由三个物理卷 /dev/sda1、/dev/sdb1 和 /dev/sdc1组成。

完成此步骤后,卷组 myvg 将包含 /dev/sda1 和 /dev/sdb1。第二个卷组 yourvg 将包含 /dev/sdc1。

使用

pvscan命令确定卷组中目前有多少可用空间。#

pvscanPV /dev/sda1 VG myvg lvm2 [17.15 GB / 0 free] PV /dev/sdb1 VG myvg lvm2 [17.15 GB / 12.15 GB free] PV /dev/sdc1 VG myvg lvm2 [17.15 GB / 15.80 GB free] Total: 3 [51.45 GB] / in use: 3 [51.45 GB] / in no VG: 0 [0 ]使用

pvmove命令将/dev/sdc1中所有使用的物理扩展移动到/dev/sdb1。执行pvmove命令可能需要很长时间。在一个集群中,

pvmove命令只能移动只在单一节点中活跃的逻辑卷。#

pvmove /dev/sdc1 /dev/sdb1/dev/sdc1: Moved: 14.7% /dev/sdc1: Moved: 30.3% /dev/sdc1: Moved: 45.7% /dev/sdc1: Moved: 61.0% /dev/sdc1: Moved: 76.6% /dev/sdc1: Moved: 92.2% /dev/sdc1: Moved: 100.0%转移数据后,您可以看到

/dev/sdc1中的所有空间都可用。#

pvscanPV /dev/sda1 VG myvg lvm2 [17.15 GB / 0 free] PV /dev/sdb1 VG myvg lvm2 [17.15 GB / 10.80 GB free] PV /dev/sdc1 VG myvg lvm2 [17.15 GB / 17.15 GB free] Total: 3 [51.45 GB] / in use: 3 [51.45 GB] / in no VG: 0 [0 ]要创建新卷组

yourvg,使用vgsplit命令分割卷组myvg。下面的命令将卷组

yourvg从卷组myvg中分割,将物理卷/dev/sdc1移动到新的卷组yourvg中。#

lvchange -a n /dev/myvg/mylv#vgsplit myvg yourvg /dev/sdc1Volume group "yourvg" successfully split from "myvg"您可以使用

vgs查看这两个卷组的属性。#

vgsVG #PV #LV #SN Attr VSize VFree myvg 2 1 0 wz--n- 34.30G 10.80G yourvg 1 0 0 wz--n- 17.15G 17.15G创建新的卷组后,创建新逻辑卷

yourlv。#

lvcreate -L 5G -n yourlv yourvgLogical volume "yourlv" created在新逻辑卷中创建文件系统并挂载它。

#

mkfs.ext4 /dev/yourvg/yourlvmke2fs 1.44.3 (10-July-2018) Creating filesystem with 524288 4k blocks and 131072 inodes Filesystem UUID: 616da032-8a48-4cd7-8705-bd94b7a1c8c4 Superblock backups stored on blocks: 32768, 98304, 163840, 229376, 294912 Allocating group tables: done Writing inode tables: done Creating journal (16384 blocks): done Writing superblocks and filesystem accounting information: done #mount /dev/yourvg/yourlv /mnt

6.5. 重命名 LVM 卷组

这个过程使用命令行 LVM 接口重新命名现有卷组。

流程

如果在集群环境中存在卷组,在其活跃的所有节点上取消激活该卷组。对每个这样的节点运行以下命令:

[root@node-n]# vgchange --activate n vg-name使用

vgrename程序重新命名现有卷组:# vgrename original-vg-name new-vg-name

另外,您还可以指定到该设备的完整路径:

# vgrename /dev/original-vg-name /dev/new-vg-name

其它资源

-

vgrename(8)man page

6.6. 将卷组移动到另一个系统中

您可以将整个 LVM 卷组移动到另一个系统中。建议您使用 vgexport 和 vgimport 命令进行此操作。

您可以使用 vgimport 命令的 --force 参数。这可让您导入缺少物理卷的卷组,然后运行 vgreduce --removemissing 命令。

vgexport 命令使系统无法访问不活跃的卷组,这样就可以分离其物理卷。在通过 vgexport 命令使一个卷组不活跃后,可以使用 vgimport 命令使其可以重新被其他机器访问。

要从一个系统移动卷组到另一个系统,,执行以下步骤:

- 确定没有用户正在访问卷组中激活卷中的文件,然后卸载逻辑卷。

-

使用

vgchange命令的-a n参数将卷组标记为不活跃,这样可防止卷组中进行任何进一步的操作。 使用

vgexport命令导出卷组。这样可防止您要将其从中删除的系统访问该卷组。在导出卷组后,执行

pvscan命令时物理卷会在导出的卷组中显示,如下例所示。#

pvscanPV /dev/sda1 is in exported VG myvg [17.15 GB / 7.15 GB free] PV /dev/sdc1 is in exported VG myvg [17.15 GB / 15.15 GB free] PV /dev/sdd1 is in exported VG myvg [17.15 GB / 15.15 GB free] ...当关闭系统时,您可以拔出组成该卷组的磁盘并将其连接到新系统。

-

当磁盘插入新系统时,,使用

vgimport命令导入卷组,并使其可以被新系统访问。 -

使用

vgchange命令的-a y参数激活卷组。 - 挂载文件系统使其可使用。

6.7. 从卷组中删除物理卷

要从卷组中删除未使用的物理卷,请使用 vgreduce 命令。vgreduce 命令通过删除一个或者多个空物理卷来缩小卷组的容量。这样就可以使不同的卷组自由使用那些物理卷,或者将其从系统中删除。

在从卷组中删除物理卷前,您可以使用 pvdisplay 命令确定物理卷没有被任何逻辑卷使用。

# pvdisplay /dev/hda1

-- Physical volume ---

PV Name /dev/hda1

VG Name myvg

PV Size 1.95 GB / NOT usable 4 MB [LVM: 122 KB]

PV# 1

PV Status available

Allocatable yes (but full)

Cur LV 1

PE Size (KByte) 4096

Total PE 499

Free PE 0

Allocated PE 499

PV UUID Sd44tK-9IRw-SrMC-MOkn-76iP-iftz-OVSen7

如果物理卷仍在使用,将需要用 pvmove 命令将数据迁移到另一个物理卷中。然后使用 vgreduce 命令删除物理卷。

以下命令可从卷组 /dev/hda1 中删除物理卷 my_volume_group。

# vgreduce my_volume_group /dev/hda1

如果逻辑卷包含失败的物理卷,您就无法使用该逻辑卷。要从卷组中删除缺少的物理卷,可以使用 vgreduce 命令的 --removemissing 参数,如果没有在缺少物理卷中分配的逻辑卷。

如果物理卷没有包含 mirror 片段类型的逻辑卷的镜像镜像,您可以使用 vgreduce --removemissing --mirrorsonly --force 命令从镜像中删除该镜像。这样只删除从物理卷中镜像镜像的逻辑卷。

6.8. 删除 LVM 卷组

这个过程使用命令行 LVM 接口删除现有卷组。

先决条件

- 卷组没有包含逻辑卷。要从卷组中删除逻辑卷,请参考 第 4.9 节 “删除 LVM 逻辑卷”。

流程

如果卷组存在于集群的环境中,在所有节点上停止卷组的锁定空间。在除您要删除的节点外的所有节点上使用以下命令:

[root@node-n]# vgchange --lockstop vg-name等待锁定停止。

要删除卷组,使用

vgremove实用程序:# vgremove vg-name Volume group "vg-name" successfully removed

其它资源

-

vgremove(8)man page

6.9. 其它资源

-

vgchange(8)man page

第 7 章 管理 LVM 物理卷

您可以使用各种命令和步骤来管理 LVM 物理卷。

7.1. 扫描用作物理卷的块设备

您可以使用 lvmdiskscan 命令扫描作为物理卷使用的块设备,如下例所示。

# lvmdiskscan

/dev/ram0 [ 16.00 MB]

/dev/sda [ 17.15 GB]

/dev/root [ 13.69 GB]

/dev/ram [ 16.00 MB]

/dev/sda1 [ 17.14 GB] LVM physical volume

/dev/VolGroup00/LogVol01 [ 512.00 MB]

/dev/ram2 [ 16.00 MB]

/dev/new_vg/lvol0 [ 52.00 MB]

/dev/ram3 [ 16.00 MB]

/dev/pkl_new_vg/sparkie_lv [ 7.14 GB]

/dev/ram4 [ 16.00 MB]

/dev/ram5 [ 16.00 MB]

/dev/ram6 [ 16.00 MB]

/dev/ram7 [ 16.00 MB]

/dev/ram8 [ 16.00 MB]

/dev/ram9 [ 16.00 MB]

/dev/ram10 [ 16.00 MB]

/dev/ram11 [ 16.00 MB]

/dev/ram12 [ 16.00 MB]

/dev/ram13 [ 16.00 MB]

/dev/ram14 [ 16.00 MB]

/dev/ram15 [ 16.00 MB]

/dev/sdb [ 17.15 GB]

/dev/sdb1 [ 17.14 GB] LVM physical volume

/dev/sdc [ 17.15 GB]

/dev/sdc1 [ 17.14 GB] LVM physical volume

/dev/sdd [ 17.15 GB]

/dev/sdd1 [ 17.14 GB] LVM physical volume

7 disks

17 partitions

0 LVM physical volume whole disks

4 LVM physical volumes7.2. 为物理卷设置分区类型

如果您将整个磁盘作为您的物理卷使用,那么磁盘就不能有分区表。对于 DOS 磁盘分区,应该使用 fdisk 或者 cfdisk 命令或等同的命令将分区 id 设为 0x8e。对于整个磁盘设备,分区表必须被删除,这样会有效地破坏磁盘中的所有数据。您可以用以下命令将现有分区表的第一个扇区归零来删除分区表:

# dd if=/dev/zero of=PhysicalVolume bs=512 count=17.3. 重新定义 LVM 物理卷大小

如果您由于某种原因需要更改基本块设备的大小,使用 pvresize 命令以新大小更新 LVM。您可以在 LVM 正在使用物理卷时执行这个命令。

7.4. 删除物理卷

如果 LVM 不再使用某个设备,可以使用 pvremove 命令删除 LVM 标签。执行 pvremove 命令会将空白物理卷中的 LVM 元数据归零。

如果您要删除的物理卷目前是卷组的一部分,则必须使用 vgreduce 命令将其从卷组中删除。

# pvremove /dev/ram15

Labels on physical volume "/dev/ram15" successfully wiped7.5. 在卷组中添加物理卷

要在现有卷组中添加物理卷,使用 vgextend 命令。vgextend 命令通过添加一个或者多个可用物理卷来增加卷组的容量。

以下命令将物理卷 /dev/sdf1 添加到卷组 vg1 中。

# vgextend vg1 /dev/sdf17.6. 从卷组中删除物理卷

要从卷组中删除未使用的物理卷,请使用 vgreduce 命令。vgreduce 命令通过删除一个或者多个空物理卷来缩小卷组的容量。这样就可以使不同的卷组自由使用那些物理卷,或者将其从系统中删除。

在从卷组中删除物理卷前,您可以使用 pvdisplay 命令确定物理卷没有被任何逻辑卷使用。

# pvdisplay /dev/hda1

-- Physical volume ---

PV Name /dev/hda1

VG Name myvg

PV Size 1.95 GB / NOT usable 4 MB [LVM: 122 KB]

PV# 1

PV Status available

Allocatable yes (but full)

Cur LV 1

PE Size (KByte) 4096

Total PE 499

Free PE 0

Allocated PE 499

PV UUID Sd44tK-9IRw-SrMC-MOkn-76iP-iftz-OVSen7

如果物理卷仍在使用,将需要用 pvmove 命令将数据迁移到另一个物理卷中。然后使用 vgreduce 命令删除物理卷。

以下命令可从卷组 /dev/hda1 中删除物理卷 my_volume_group。

# vgreduce my_volume_group /dev/hda1

如果逻辑卷包含失败的物理卷,您就无法使用该逻辑卷。要从卷组中删除缺少的物理卷,您可以使用 vgreduce 命令的 --removemissing 参数,如果没有在缺少物理卷中分配的逻辑卷。

如果物理卷没有包含 mirror 片段类型的逻辑卷的镜像镜像,您可以使用 vgreduce --removemissing --mirrorsonly --force 命令从镜像中删除该镜像。这样只删除从物理卷中镜像镜像的逻辑卷。

第 8 章 显示 LVM 组件

LVM 提供各种显示 LVM 组件和自定义显示的方法。这部分总结了基本 LVM 显示命令的使用。

8.1. 使用 lvm 命令显示 LVM 信息

lvm 命令提供一些内置选项,您可以使用它们显示 LVM 支持和配置的信息。

lvm devtypes显示可识别的内置块设备类型

lvm formats显示可识别的元数据格式。

lvm help显示 LVM 帮助文本。

lvm segtypes显示可识别的逻辑卷片段类型。

lvm tags显示此主机上定义的所有标签。

lvm version显示当前版本信息。

8.2. 显示物理卷

您可以使用三个命令来显示 LVM 物理卷属性: pvs、pvdisplay 和 pvscan。

pvs 命令提供了可以对其进行格式配置的物理卷信息,每行显示一个物理卷。pvs 命令提供大量格式控制,对脚本很有用。

pvdisplay 命令为每个物理卷提供详细的多行输出。它以固定格式显示物理属性(大小、扩展、卷组等等)。

以下示例显示了 pvdisplay 命令的单个物理卷的输出结果。

# pvdisplay

--- Physical volume ---

PV Name /dev/sdc1

VG Name new_vg

PV Size 17.14 GB / not usable 3.40 MB

Allocatable yes

PE Size (KByte) 4096

Total PE 4388

Free PE 4375

Allocated PE 13

PV UUID Joqlch-yWSj-kuEn-IdwM-01S9-XO8M-mcpsVe

pvscan 命令为物理卷扫描系统中所有支持的 LVM 块设备。

以下命令显示所有找到的物理设备:

# pvscan

PV /dev/sdb2 VG vg0 lvm2 [964.00 MB / 0 free]

PV /dev/sdc1 VG vg0 lvm2 [964.00 MB / 428.00 MB free]

PV /dev/sdc2 lvm2 [964.84 MB]

Total: 3 [2.83 GB] / in use: 2 [1.88 GB] / in no VG: 1 [964.84 MB]

您可以在 lvm.conf 文件中定义过滤器,以便这个命令避免扫描特定的物理卷。

8.3. 显示卷组

您可以使用两个命令来显示 LVM 卷组的属性: vgs 和 vgdisplay。vgscan 命令为卷组扫描系统中所有支持的 LVM 块设备,也可以用来显示现有卷组。

vgs 命令提供了可以对其进行格式配置的卷组信息,每行显示一个卷组。vgs 命令提供大量格式控制,对脚本很有用。

vgdisplay 命令以固定格式显示卷组属性(比如大小、扩展、物理卷数目等等)。下面的例子显示了 vgdisplay 命令输出卷组 new_vg 的信息。如果您没有指定卷组,则会显示所有现有的卷组。

# vgdisplay new_vg

--- Volume group ---

VG Name new_vg

System ID

Format lvm2

Metadata Areas 3

Metadata Sequence No 11

VG Access read/write

VG Status resizable

MAX LV 0

Cur LV 1

Open LV 0

Max PV 0

Cur PV 3

Act PV 3

VG Size 51.42 GB

PE Size 4.00 MB

Total PE 13164

Alloc PE / Size 13 / 52.00 MB

Free PE / Size 13151 / 51.37 GB

VG UUID jxQJ0a-ZKk0-OpMO-0118-nlwO-wwqd-fD5D32

以下示例显示了 vgscan 命令的输出结果。

# vgscan

Reading all physical volumes. This may take a while...

Found volume group "new_vg" using metadata type lvm2

Found volume group "officevg" using metadata type lvm28.4. 显示逻辑卷

您可以使用三个命令来显示 LVM 逻辑卷的属性: lvs、lvdisplay 和 lvscan。

lvs 命令提供了可以对其进行格式配置的逻辑卷信息,每行显示一个逻辑卷。lvs 命令提供大量格式控制,对脚本很有用。

lvdisplay 命令以固定格式显示逻辑卷属性(比如大小、布局和映射)。

以下命令显示 vg00 中的 lvol2 的属性。如果已经为原始逻辑卷创建了快照逻辑卷,这个命令还会显示所有快照逻辑卷及其状态(活跃或者不活跃)的列表。

# lvdisplay -v /dev/vg00/lvol2

lvscan 命令扫描系统中所有逻辑卷并将其列出,如下例所示。

# lvscan

ACTIVE '/dev/vg0/gfslv' [1.46 GB] inherit第 9 章 LVM 的自定义报告

LVM 提供了广泛的配置和命令行选项来生成自定义报告,并过滤报告输出。有关 LVM 报告功能和功能的完整论述请查看 lvmreport(7)手册页。

您可以使用 pvs、lvs 和 vgs 命令生成 LVM 对象的简洁自定义报告。这些命令生成的报告包括每行对象的输出结果。每行包含与对象相关的属性字段排序列表。选择要报告的对象有五种方法:根据物理卷、卷组、逻辑卷、物理卷片段以及逻辑卷片段。

您可以使用 lvm fullreport 命令报告物理卷、卷组、逻辑卷、物理卷片段以及逻辑卷片段的信息。有关这个命令及其功能的详情,请参考 lvm-fullreport(8)man page。

LVM 支持日志报告,其中包含在 LVM 命令执行期间收集的完整对象识别操作、消息和每个对象状态的日志。有关 LVM 日志报告的详情,请查看 lvmreport(7)手册页。

9.1. 控制 LVM 显示的格式

无论您使用 pvs、lvs 或 vgs 命令,都要决定默认字段显示和排序顺序。您可以使用以下参数来控制这些命令的输出结果:

您可以使用

-o参数更改显示哪些字段为默认字段。例如:以下命令只显示物理卷名称和大小。#

pvs -o pv_name,pv_sizePV PSize /dev/sdb1 17.14G /dev/sdc1 17.14G /dev/sdd1 17.14G您可以使用加号(+)在输出结果中附加一个字段,该符号与 -o 参数结合使用。

下面的例子除默认字段外还显示物理卷 UUID。

#

pvs -o +pv_uuidPV VG Fmt Attr PSize PFree PV UUID /dev/sdb1 new_vg lvm2 a- 17.14G 17.14G onFF2w-1fLC-ughJ-D9eB-M7iv-6XqA-dqGeXY /dev/sdc1 new_vg lvm2 a- 17.14G 17.09G Joqlch-yWSj-kuEn-IdwM-01S9-X08M-mcpsVe /dev/sdd1 new_vg lvm2 a- 17.14G 17.14G yvfvZK-Cf31-j75k-dECm-0RZ3-0dGW-UqkCS在命令中添加

-v参数包含一些额外的字段。例如:pvs -v命令除默认字段外还显示DevSize和PV UUID字段。#

pvs -vScanning for physical volume names PV VG Fmt Attr PSize PFree DevSize PV UUID /dev/sdb1 new_vg lvm2 a- 17.14G 17.14G 17.14G onFF2w-1fLC-ughJ-D9eB-M7iv-6XqA-dqGeXY /dev/sdc1 new_vg lvm2 a- 17.14G 17.09G 17.14G Joqlch-yWSj-kuEn-IdwM-01S9-XO8M-mcpsVe /dev/sdd1 new_vg lvm2 a- 17.14G 17.14G 17.14G yvfvZK-Cf31-j75k-dECm-0RZ3-0dGW-tUqkCS--noheadings参数绕过标题行。这对编写脚本非常有用。以下示例将

--noheadings参数与pv_name参数结合使用,该参数将生成所有物理卷的列表。#

pvs --noheadings -o pv_name/dev/sdb1 /dev/sdc1 /dev/sdd1--separator separator参数使用分隔符来分隔不同的字段。下面的例子使用等号(=)分隔

pvs命令的默认输出字段。#

pvs --separator =PV=VG=Fmt=Attr=PSize=PFree /dev/sdb1=new_vg=lvm2=a-=17.14G=17.14G /dev/sdc1=new_vg=lvm2=a-=17.14G=17.09G /dev/sdd1=new_vg=lvm2=a-=17.14G=17.14G要在使用

separator参数时保持字段一致,请使用separator参数和--aligned参数。#

pvs --separator = --alignedPV =VG =Fmt =Attr=PSize =PFree /dev/sdb1 =new_vg=lvm2=a- =17.14G=17.14G /dev/sdc1 =new_vg=lvm2=a- =17.14G=17.09G /dev/sdd1 =new_vg=lvm2=a- =17.14G=17.14G

您可以使用 lvs 或 vgs 命令的 -P 参数显示在其他情况下不会输出中的失败卷的信息。

有关显示参数的完整列表请参考 pvs(8)、vgs(8)和 lvs(8)man page。

卷组字段可与物理卷(和物理卷片段)字段或者逻辑卷(和逻辑卷片段)字段混合,但物理卷和逻辑卷字段无法混合。例如:以下命令可显示每行物理卷的输出结果。

# vgs -o +pv_name

VG #PV #LV #SN Attr VSize VFree PV

new_vg 3 1 0 wz--n- 51.42G 51.37G /dev/sdc1

new_vg 3 1 0 wz--n- 51.42G 51.37G /dev/sdd1

new_vg 3 1 0 wz--n- 51.42G 51.37G /dev/sdb19.2. LVM 对象显示字段

这部分提供了一组表,列出您可以使用 pvs、vgs 和 lvs 命令显示的 LVM 对象信息。

为方便起见,字段名称前缀如果与命令的默认名称匹配就可以省略。例如,在 pvs 命令中,name 代表 pv_name,但使用 vgs 命令时,name 将解释为 vg_name。

执行以下命令等同于执行 pvs -o pv_free。

# pvs -o free

PFree

17.14G

17.09G

17.14G

pvs、vgs 和 lvs 输出中的属性字段中的字符数量可能会增加。现有字符字段不会改变位置,但可能会在末尾添加新字段。在编写用于搜索特定属性字符的脚本时,您应该考虑这一点,根据该字符的相对位置搜索该字符,但不考虑其相对位置到字段末尾的位置。例如:要在 lv_attr 字段的起始字节中搜索字符 p,您可以搜索字符串 "^/……..p/",但您不应该搜索字符串 "/*p$/"。

表 9.1 “pvs 命令显示字段” 列出 pvs 命令的显示参数,同时列出在标头显示和描述字段显示的字段名称。

表 9.1. pvs 命令显示字段

| 参数 | 标头 | 描述 |

|---|---|---|

|

| DevSize | 创建物理卷的基本设备的大小 |

|

| 1st PE | 在基础设备中调整到第一个物理扩展的起始位置 |

|

| Attr | 物理卷状态:可分配(a)或者导出的(x)。 |

|

| Fmt |

物理卷的元数据格式( |

|

| PFree | 物理卷中剩余的可用空间 |

|

| PV | 物理卷名称 |

|

| Alloc | 已使用的物理扩展数目 |

|

| PE | 物理扩展数目 |

|

| SSize | 物理卷的片段大小 |

|

| Start | 物理卷片段的起始物理扩展 |

|

| PSize | 物理卷的大小 |

|

| PV 标签 | 附加到物理卷的 LVM 标签 |

|

| Used | 目前物理卷中已经使用的空间量 |

|

| PV UUID | 物理卷的 UUID |

pvs 命令默认显示以下字段: pv_name、vg_name、pv_fmt、pv_attr、pv_size、pv_free。显示会根据 pv_name 进行排序。

# pvs

PV VG Fmt Attr PSize PFree

/dev/sdb1 new_vg lvm2 a- 17.14G 17.14G

/dev/sdc1 new_vg lvm2 a- 17.14G 17.09G

/dev/sdd1 new_vg lvm2 a- 17.14G 17.13G

在 pvs 命令中使用 -v 参数会将以下字段添加到默认显示中: dev_size、pv_uuid。

# pvs -v

Scanning for physical volume names

PV VG Fmt Attr PSize PFree DevSize PV UUID

/dev/sdb1 new_vg lvm2 a- 17.14G 17.14G 17.14G onFF2w-1fLC-ughJ-D9eB-M7iv-6XqA-dqGeXY

/dev/sdc1 new_vg lvm2 a- 17.14G 17.09G 17.14G Joqlch-yWSj-kuEn-IdwM-01S9-XO8M-mcpsVe

/dev/sdd1 new_vg lvm2 a- 17.14G 17.13G 17.14G yvfvZK-Cf31-j75k-dECm-0RZ3-0dGW-tUqkCS

您可以使用 pvs 命令的 --segments 参数显示每个物理卷片段的信息。一个片段就是一组扩展。查看片段在想查看逻辑卷是否碎片时很有用。

pvs --segments 命令默认显示以下字段: pv_name、vg_name、pv_fmt、pv_attr、pv_size、pv_free、pvseg_start、pvseg_size。该显示根据物理卷中的 pv_name 和 pvseg_size 进行排序。

# pvs --segments

PV VG Fmt Attr PSize PFree Start SSize

/dev/hda2 VolGroup00 lvm2 a- 37.16G 32.00M 0 1172

/dev/hda2 VolGroup00 lvm2 a- 37.16G 32.00M 1172 16

/dev/hda2 VolGroup00 lvm2 a- 37.16G 32.00M 1188 1

/dev/sda1 vg lvm2 a- 17.14G 16.75G 0 26

/dev/sda1 vg lvm2 a- 17.14G 16.75G 26 24

/dev/sda1 vg lvm2 a- 17.14G 16.75G 50 26

/dev/sda1 vg lvm2 a- 17.14G 16.75G 76 24

/dev/sda1 vg lvm2 a- 17.14G 16.75G 100 26

/dev/sda1 vg lvm2 a- 17.14G 16.75G 126 24

/dev/sda1 vg lvm2 a- 17.14G 16.75G 150 22

/dev/sda1 vg lvm2 a- 17.14G 16.75G 172 4217

/dev/sdb1 vg lvm2 a- 17.14G 17.14G 0 4389

/dev/sdc1 vg lvm2 a- 17.14G 17.14G 0 4389

/dev/sdd1 vg lvm2 a- 17.14G 17.14G 0 4389

/dev/sde1 vg lvm2 a- 17.14G 17.14G 0 4389

/dev/sdf1 vg lvm2 a- 17.14G 17.14G 0 4389

/dev/sdg1 vg lvm2 a- 17.14G 17.14G 0 4389

您可以使用 pvs -a 来查看被 LVM 探测到的设备还没有初始化为 LVM 物理卷。

# pvs -a

PV VG Fmt Attr PSize PFree

/dev/VolGroup00/LogVol01 -- 0 0

/dev/new_vg/lvol0 -- 0 0

/dev/ram -- 0 0

/dev/ram0 -- 0 0

/dev/ram2 -- 0 0

/dev/ram3 -- 0 0

/dev/ram4 -- 0 0

/dev/ram5 -- 0 0

/dev/ram6 -- 0 0

/dev/root -- 0 0

/dev/sda -- 0 0

/dev/sdb -- 0 0

/dev/sdb1 new_vg lvm2 a- 17.14G 17.14G

/dev/sdc -- 0 0

/dev/sdc1 new_vg lvm2 a- 17.14G 17.09G

/dev/sdd -- 0 0

/dev/sdd1 new_vg lvm2 a- 17.14G 17.14G

表 9.2 “vgs 显示字段” 列出 vgs 命令的显示参数,同时列出在标头显示和描述字段显示的字段名称。

表 9.2. vgs 显示字段

| 参数 | 标头 | 描述 |

|---|---|---|

|

| #LV | 卷组包含的逻辑卷数 |

|

| MaxLV | 卷组中最多允许的逻辑卷数目(如果没有限制就是 0) |

|

| MaxPV | 卷组中最多允许的物理卷数目(如果没有限制就是 0) |

|

| #PV | 定义卷组的物理卷数目 |

|

| #SN | 卷组包含的快照数 |

|

| Attr | 卷组状态:可写入(w)、只读(r)、可重新定义大小(z)、导出的(x)、部分的(p)和集群的(c)。 |

|

| #Ext | 卷组中的物理扩展数目 |

|

| Ext | 卷组中物理扩展的大小 |

|

| Fmt |

卷组的元数据格式( |

|

| VFree | 卷组中剩余可用空间大小 |

|

| Free | 卷组中可用物理扩展数目 |

|

| VG | 卷组名称 |

|

| Seq | 代表修正卷组的数 |

|

| VSize | 卷组大小 |

|

| SYS ID | LVM1 系统 ID |

|

| VG Tags | 附加到卷组中的 LVM 标签 |

|

| VG UUID | 卷组的 UUID |

vgs 命令默认显示以下字段: vg_name、pv_count、lv_count、snap_count、vg_attr、vg_size、vg_free。显示根据 vg_name 进行排序。

# vgs

VG #PV #LV #SN Attr VSize VFree

new_vg 3 1 1 wz--n- 51.42G 51.36G

在 vgs 命令中使用 -v 参数会将以下字段添加到默认显示中: vg_extent_size、vg_uuid。

# vgs -v

Finding all volume groups

Finding volume group "new_vg"

VG Attr Ext #PV #LV #SN VSize VFree VG UUID

new_vg wz--n- 4.00M 3 1 1 51.42G 51.36G jxQJ0a-ZKk0-OpMO-0118-nlwO-wwqd-fD5D32

表 9.3 “LVS 显示字段” 列出 lvs 命令的显示参数,同时列出在标头显示和描述字段显示的字段名称。

在以后的 Red Hat Enterprise Linux 发行本中,lvs 命令的输出结果可能会有所不同,以及输出中的附加字段。但是,这些字段的顺序将保持不变,所有附加字段也会在显示的末尾出现。

表 9.3. LVS 显示字段

| 参数 | 标头 | 描述 |

|---|---|---|

|

*

* | Chunk | 快照卷的单位大小 |

|

| Copy% |

镜像卷的同步百分比 ; 还在使用 |

|

| Devices | 组成逻辑卷的基本设备:物理卷、逻辑卷以及启动物理扩展和逻辑扩展 |

|

| Ancestors | 对于精简池快照,逻辑卷的祖先 |

|

| 子代 | 对于精简池快照,逻辑卷的子代数 |

|

| Attr | 逻辑卷的状态。逻辑卷属性字节如下: * Bit 1: 卷类型: (m)irrored, (M)irrored without initial sync, (o)rigin, (O)rigin with merging snapshot, (r)aid, ®aid without initial sync, (s)napshot, merging (S)napshot, (p)vmove, (v)irtual, mirror or raid (i)mage, mirror or raid (I)mage out-of-sync, mirror (l)og device, under (c)onversion, thin (V)olume, (t)hin pool, (T)hin pool data, raid or thin pool m(e)tadata or pool metadata spare, * Bit 2: 权限 : (w)riteable, (r)ead-only, ®ead-only activation of non-read-only volume

* Bit 3: 分配策略: (a)nywhere, (c)ontiguous, (i)nherited, c(l)ing, (n)ormal.如果在修改分配时锁定了卷,会使用大写,例如在执行 * Bit 4: 固定的 (m)inor * Bit 5: 状态: (a)ctive, (s)uspended, (I)nvalid snapshot, invalid (S)uspended snapshot, snapshot (m)erge failed, suspended snapshot (M)erge failed, mapped (d)evice present without tables, mapped device present with (i)nactive table * Bit 6: 设备 (o)pen * Bit 7: 目标类型 : (m)irror, (r)aid, (s)napshot, (t)hin, (u)nknown, (v)irtual.这组逻辑卷同时与同一内核目标相关。因此,如果它们使用原始的 device-mapper mirror 内核驱动程序,则镜像日志、镜像日志以及镜像本身会显示(m),而 raid 等同于使用 md raid 内核驱动程序。使用原始 device-mapper 驱动程序的快照会出现(s),使用精简置备驱动程序的精简卷快照会出现(t)。 * Bit 8: Newly-allocated data blocks are overwritten with blocks of (z)eroes before use.

* Bit 9: 卷健康 : (p)artial, (r)efresh needed, (m)ismatches exist, (w)ritemostly. (p)artial signifies that one or more of the Physical Volumes this Logical Volume uses is missing from the system. (r)efresh signifies that one or more of the Physical Volumes this RAID Logical Volume uses had suffered a write error.写入错误可能是由物理卷临时失败造成的,或表示它已经失败。应该刷新或者替换该设备。(m)ismatches 表示 RAID 逻辑卷有不和谐的阵列部分。通过在 RAID 逻辑卷中启动 * Bit 10: s(k)ip activation: 这个卷被标记为在激活的过程中跳过它。 |

|

| KMaj | 逻辑卷的真实主设备号码(如果不活跃则为 -1) |

|

| KMIN | 逻辑卷的真实从设备号码(如果是不活跃则为 -1) |

|

| Maj | 逻辑卷持久的主设备号码(如果未指定则为 -1) |

|

| Min | 逻辑卷持久的从设备号(如果未指定则为 -1) |

|

| LV | 逻辑卷名称 |

|

| LSize | 逻辑卷的大小 |

|

| LV Tags | 附加到逻辑卷的 LVM 标签 |

|

| LV UUID | 逻辑卷的 UUID。 |

|

| Log | 镜像日志所在的设备 |

|

| 模块 | 使用此逻辑卷所需内核 device-mapper 目标 |

|

| Move |

使用 |

|

| Origin | 快照卷的源设备 |

|

*

* | Region | 镜像的逻辑卷的单元大小 |

|

| #Seg | 逻辑卷中片段的数 |

|

| SSize | 逻辑卷中片段的大小 |

|

| Start | 逻辑卷中片段的开始位置 |

|

| Seg Tags | 附加到逻辑卷片段的 LVM 标签 |

|

| 类型 | 逻辑卷的片段类型(例如:镜像、条状、线性) |

|

| Snap% | 已使用的快照卷的比例 |

|

| #Str | 逻辑卷中条带或者镜像的数目 |

|

*

* | Stripe | 条状逻辑卷中条状逻辑卷的单元大小 |

lvs 命令默认提供以下显示。默认显示会根据卷组中的 vg_name 和 lv_name 进行排序。

# lvs

LV VG Attr LSize Pool Origin Data% Meta% Move Log Cpy%Sync Convert

origin VG owi-a-s--- 1.00g

snap VG swi-a-s--- 100.00m origin 0.00

lvs 命令的常见用法是在命令中附加 devices 以显示组成逻辑卷的基本设备。这个示例还指定 -a 选项显示逻辑卷组件的内部卷,比如 RAID 镜像,并用括号括起来。这个示例包括 RAID 卷、条状卷和一个精简池卷。

# lvs -a -o +devices

LV VG Attr LSize Pool Origin Data% Meta% Move Log Cpy%Sync Convert Devices

raid1 VG rwi-a-r--- 1.00g 100.00 raid1_rimage_0(0),raid1_rimage_1(0)

[raid1_rimage_0] VG iwi-aor--- 1.00g /dev/sde1(7041)

[raid1_rimage_1] VG iwi-aor--- 1.00g /dev/sdf1(7041)

[raid1_rmeta_0] VG ewi-aor--- 4.00m /dev/sde1(7040)

[raid1_rmeta_1] VG ewi-aor--- 4.00m /dev/sdf1(7040)

stripe1 VG -wi-a----- 99.95g /dev/sde1(0),/dev/sdf1(0)

stripe1 VG -wi-a----- 99.95g /dev/sdd1(0)

stripe1 VG -wi-a----- 99.95g /dev/sdc1(0)

[lvol0_pmspare] rhel_host-083 ewi------- 4.00m /dev/vda2(0)

pool00 rhel_host-083 twi-aotz-- <4.79g 72.90 54.69 pool00_tdata(0)

[pool00_tdata] rhel_host-083 Twi-ao---- <4.79g /dev/vda2(1)

[pool00_tmeta] rhel_host-083 ewi-ao---- 4.00m /dev/vda2(1226)

root rhel_host-083 Vwi-aotz-- <4.79g pool00 72.90

swap rhel_host-083 -wi-ao---- 820.00m /dev/vda2(1227)

将 -v 参数与 lvs 命令一起使用会将以下字段添加到默认显示中: seg_count、lv_major、lv_minor、lv_kernel_major、lv_kernel_minor、lv_uuid。

# lvs -v

Finding all logical volumes

LV VG #Seg Attr LSize Maj Min KMaj KMin Origin Snap% Move Copy% Log Convert LV UUID

lvol0 new_vg 1 owi-a- 52.00M -1 -1 253 3 LBy1Tz-sr23-OjsI-LT03-nHLC-y8XW-EhCl78

newvgsnap1 new_vg 1 swi-a- 8.00M -1 -1 253 5 lvol0 0.20 1ye1OU-1cIu-o79k-20h2-ZGF0-qCJm-CfbsIx

您可以使用 lvs 命令的 --segments 参数显示用来记录片段信息的默认列。当使用 segments 参数时,seg 前缀是可选的。lvs --segments 命令默认显示以下字段: lv_name、vg_name、lv_attr、stripes、segtype、seg_size。默认显示根据卷组中的 vg_name、lv_name 和逻辑卷中的 seg_start 进行排序。如果逻辑卷有碎片化的问题,这个命令的输出会显示相关信息。

# lvs --segments

LV VG Attr #Str Type SSize

LogVol00 VolGroup00 -wi-ao 1 linear 36.62G

LogVol01 VolGroup00 -wi-ao 1 linear 512.00M

lv vg -wi-a- 1 linear 104.00M

lv vg -wi-a- 1 linear 104.00M

lv vg -wi-a- 1 linear 104.00M

lv vg -wi-a- 1 linear 88.00M

将 -v 参数与 lvs --segments 命令一起使用会将以下字段添加到默认显示中: seg_start、stripesize、chunksize。

# lvs -v --segments

Finding all logical volumes

LV VG Attr Start SSize #Str Type Stripe Chunk

lvol0 new_vg owi-a- 0 52.00M 1 linear 0 0

newvgsnap1 new_vg swi-a- 0 8.00M 1 linear 0 8.00K

下面的例子显示,在配置了一个逻辑卷的系统中 lvs 命令的默认输出结果,后面是指定了 segments 参数的 lvs 命令的默认输出。

#lvsLV VG Attr LSize Origin Snap% Move Log Copy% lvol0 new_vg -wi-a- 52.00M #lvs --segmentsLV VG Attr #Str Type SSize lvol0 new_vg -wi-a- 1 linear 52.00M

9.3. LVM 报告排序

通常,lvs、vgs 或 pvs 命令的完整输出结果必须先在内部生成并存储,然后才能正确排序。您可以指定 --unbuffered 参数来在生成后马上显示未排序的输出。

要指定不同的列排序,使用任意报告命令的 -O 参数。在输出中不一定要包含这些字段。

下面的例子显示 pvs 命令的输出结果,它显示了物理卷名称、大小和可用空间。

# pvs -o pv_name,pv_size,pv_free

PV PSize PFree

/dev/sdb1 17.14G 17.14G

/dev/sdc1 17.14G 17.09G

/dev/sdd1 17.14G 17.14G下面的例子显示相同的输出结果,根据可用空间字段排序。

# pvs -o pv_name,pv_size,pv_free -O pv_free

PV PSize PFree

/dev/sdc1 17.14G 17.09G

/dev/sdd1 17.14G 17.14G

/dev/sdb1 17.14G 17.14G以下示例显示您不需要显示您要排序的字段。

# pvs -o pv_name,pv_size -O pv_free

PV PSize

/dev/sdc1 17.14G

/dev/sdd1 17.14G

/dev/sdb1 17.14G

要显示逆向排序,在使用 -O 参数后指定 -。

# pvs -o pv_name,pv_size,pv_free -O -pv_free

PV PSize PFree

/dev/sdd1 17.14G 17.14G

/dev/sdb1 17.14G 17.14G

/dev/sdc1 17.14G 17.09G9.4. 为 LVM 报告显示指定单位

要指定 LVM 报告显示的单元,使用 report 命令的 --units 参数。您可以指定 (b)ytes, (k)ilobytes, (m)egabytes, (g)igabytes, (t)erabytes, (e)xabytes, (p)etabytes, and (h)uman-readable。默认显示是人类可读的。您可以通过在 /etc/lvm/lvm.conf 文件的 global 部分设置 units 参数来覆盖默认设置。

下面的例子指定 pvs 命令的输出结果的单位为 兆字节,而不是默认的千兆字节。

# pvs --units m

PV VG Fmt Attr PSize PFree

/dev/sda1 lvm2 -- 17555.40M 17555.40M

/dev/sdb1 new_vg lvm2 a- 17552.00M 17552.00M

/dev/sdc1 new_vg lvm2 a- 17552.00M 17500.00M

/dev/sdd1 new_vg lvm2 a- 17552.00M 17552.00M默认情况下,显示的单位是 1024 的倍数。您可以使用大写字母代表单位是 1000 的倍数(B、K、M、G、T、H)。

下面的命令以默认单位(1024 的倍数)显示输出结果。

# pvs

PV VG Fmt Attr PSize PFree

/dev/sdb1 new_vg lvm2 a- 17.14G 17.14G

/dev/sdc1 new_vg lvm2 a- 17.14G 17.09G

/dev/sdd1 new_vg lvm2 a- 17.14G 17.14G下面的命令以 1000 的倍数为单位显示输出结果。

# pvs --units G

PV VG Fmt Attr PSize PFree

/dev/sdb1 new_vg lvm2 a- 18.40G 18.40G

/dev/sdc1 new_vg lvm2 a- 18.40G 18.35G

/dev/sdd1 new_vg lvm2 a- 18.40G 18.40G您也可以指定y (s)ectors(定义为 512 字节)或自定义单元。

以下示例以扇区(sector)为单位显示 pvs 命令的输出结果。

# pvs --units s

PV VG Fmt Attr PSize PFree

/dev/sdb1 new_vg lvm2 a- 35946496S 35946496S

/dev/sdc1 new_vg lvm2 a- 35946496S 35840000S

/dev/sdd1 new_vg lvm2 a- 35946496S 35946496S

下面的例子显示 pvs 命令的输出结果,单位为 4MB。

# pvs --units 4m

PV VG Fmt Attr PSize PFree

/dev/sdb1 new_vg lvm2 a- 4388.00U 4388.00U

/dev/sdc1 new_vg lvm2 a- 4388.00U 4375.00U

/dev/sdd1 new_vg lvm2 a- 4388.00U 4388.00U9.5. 以 JSON 格式显示 LVM 命令输出

您可以使用 LVM 显示命令的 --reportformat 选项以 JSON 格式显示输出结果。

以下示例以标准默认格式显示 lvs 的输出结果。

# lvs

LV VG Attr LSize Pool Origin Data% Meta% Move Log Cpy%Sync Convert

my_raid my_vg Rwi-a-r--- 12.00m 100.00

root rhel_host-075 -wi-ao---- 6.67g

swap rhel_host-075 -wi-ao---- 820.00m以下命令显示指定 JSON 格式时相同 LVM 配置的输出结果。

# lvs --reportformat json

{

"report": [

{

"lv": [

{"lv_name":"my_raid", "vg_name":"my_vg", "lv_attr":"Rwi-a-r---", "lv_size":"12.00m", "pool_lv":"", "origin":"", "data_percent":"", "metadata_percent":"", "move_pv":"", "mirror_log":"", "copy_percent":"100.00", "convert_lv":""},

{"lv_name":"root", "vg_name":"rhel_host-075", "lv_attr":"-wi-ao----", "lv_size":"6.67g", "pool_lv":"", "origin":"", "data_percent":"", "metadata_percent":"", "move_pv":"", "mirror_log":"", "copy_percent":"", "convert_lv":""},

{"lv_name":"swap", "vg_name":"rhel_host-075", "lv_attr":"-wi-ao----", "lv_size":"820.00m", "pool_lv":"", "origin":"", "data_percent":"", "metadata_percent":"", "move_pv":"", "mirror_log":"", "copy_percent":"", "convert_lv":""}

]

}

]

}

您还可以使用 output_format 设置将报告格式设置为 /etc/lvm/lvm.conf 文件中的配置选项。但是,命令行的 --reportformat 设置优先于这个设置。

9.6. 显示 LVM 命令日志

如果 log/report_command_log 配置设置启用了这个选项,则面向报告的 LVM 命令都可以报告该命令日志。您可以确定要显示的一组字段,并为此报告排序。

以下示例将 LVM 配置为为 LVM 命令生成完整日志报告。在这个示例中,您可以看到逻辑卷 lvol0 和 lvol1 都已被成功处理,就像包含该卷的卷组 VG 一样。

#lvmconfig --type full log/command_log_selectioncommand_log_selection="all" #lvsLogical Volume ============== LV LSize Cpy%Sync lvol1 4.00m 100.00 lvol0 4.00m Command Log =========== Seq LogType Context ObjType ObjName ObjGrp Msg Errno RetCode 1 status processing lv lvol0 vg success 0 1 2 status processing lv lvol1 vg success 0 1 3 status processing vg vg success 0 1 #lvchange -an vg/lvol1Command Log =========== Seq LogType Context ObjType ObjName ObjGrp Msg Errno RetCode 1 status processing lv lvol1 vg success 0 1 2 status processing vg vg success 0 1

有关配置 LVM 报告和命令日志的详情请参考 lvmreport man page。

第 10 章 配置 RAID 逻辑卷

您可以创建、激活、更改、删除、显示和使用 LVM RAID 卷。

10.1. RAID 逻辑卷

LVM 支持 RAID 0、1、4、5、6 和 10。

LVM RAID 卷有以下特征:

- LVM 创建和管理的 RAID 逻辑卷利用多设备(MD)内核驱动程序。

- 您可以从阵列中临时分割 RAID1 镜像,并在之后将其合并到阵列中。

- LVM RAID 卷支持快照。

集群

RAID 逻辑卷不是集群感知型的。

您可以只在一台机器中创建和激活 RAID 逻辑卷,但不能在多台机器中同时激活它们。

子卷

当您创建 RAID 逻辑卷时,LVM 会为阵列中的每个数据或者奇偶校验子卷创建一个元数据子卷,它是一个扩展大小。

例如:创建一个双向 RAID1 阵列会导致两个元数据子卷(lv_rmeta_0 和 lv_rmeta_1)和两个数据子卷(lv_rimage_0 和 lv_rimage_1)。同样,创建三向条带(加 1 隐式奇偶校验设备)RAID4 会产生 4 个元数据子卷(lv_rmeta_0、lv_rmeta_1、lv_rmeta_2和 lv_rmeta_3)和 4 个数据子卷(lv_rimage_0、lv_rimage_1、lv_rimage_2和 lv_rimage_3)。

完整性

当 RAID 设备失败或者发生软崩溃时,可能会丢失数据。数据存储中的软崩溃意味着,从存储设备中检索的数据与写入到那个设备中的数据不同。在 RAID LV 中添加完整性有助于缓解或防止软崩溃。要了解更多有关软崩溃和如何在 RAID LV 中添加完整性的信息,请参阅 第 10.6 节 “使用带有 RAID LV 的 DM 完整性功能”。

10.2. RAID 级别和线性支持

RAID 支持各种配置,包括 0、1、4、5、6、10 和 linear。这些 RAID 类型定义如下:

- 0 级

RAID 级别 0,通常被称为条带化数据映射技术。这意味着,要写入阵列的数据被分成条块,并在阵列的成员磁盘中写入,这样可以在成本低的情况下提供高的 I/O 性能,但不提供冗余。

许多 RAID 级别 0 的实现只在成员设备间条状分布到阵列中最小设备的大小。就是说,如果您有多个设备,它们的大小稍有不同,那么每个设备的大小都被视为与最小设备的大小相同。因此,级别 0 阵列的一般存储容量等于,硬件 RAID 中容量最小的成员磁盘的容量,或软件 RAID 中的最小成员分区的容量,在乘以阵列中的磁盘或分区的数量。

- 1 级

RAID 级别 1 或称为镜像,通过将相同数据写入阵列的每个磁盘来提供冗余,在每个磁盘上保留"镜像"副本。因为其简单且数据高度可用,RAID 1 仍然被广泛使用。级别 1 需要两个或者多个磁盘,它提供了很好的数据可靠性,提高了需要读取的应用程序的性能,但是成本相对高。

为了实现数据可靠性,需要向阵列中的所有磁盘写入相同的信息,所以 RAID 1 的成本会很高。与基于奇偶校验的其他级别(如级别 5)相比,空间的利用效率较低。然而,对空间利用率的牺牲提供了高性能:基于奇偶校验的 RAID 级别会消耗大量 CPU 资源以便获得奇偶校验,而 RAID 级别 1 只是一次向多个 RAID 成员中写入同样数据,其对 CPU 的消耗较小。因此,在使用软件 RAID 的系统中,或系统中有其他操作需要大量使用 CPU 资源时,RAID 1 可能会比使用基于奇偶校验的 RAID 级别的性能更好。

级别 1 阵列的存储容量等于硬件 RAID 中最小镜像硬盘或者软件 RAID 中最小镜像分区的容量相同。级别 1 所提供的冗余性是所有 RAID 级别中最高的,因为阵列只需要在有一个成员可以正常工作的情况下就可以提供数据。

- 级别 4

级别 4 使用单一磁盘驱动器中的奇偶校验来保护数据。奇偶校验信息根据阵列中其余成员磁盘的内容计算。然后当阵列中的一个磁盘失败时,这个信息就可以被用来重建数据。然后,在出现问题的磁盘被替换前,使用被重建的数据就可以满足 I/O 的请求。在磁盘被替换后,可以在上面重新生成数据。

因为 RAID 4 使用一个专门的偶校验磁盘,因此这个磁盘就会成为对 RAID 阵列的写入操作的一个固有的瓶颈。所以, RAID 4 较少被使用。因此,Anaconda 中并没有提供 RAID 4 这个选项。但是,如果真正需要,用户可以手动创建它。

硬件 RAID 4 的存储容量等于分区数量减一乘以最小成员分区的容量。RAID 4 阵列的性能是非对称的,即读的性能会好于写的性能。这是因为,在生成奇偶校验时,写操作会消耗额外的 CPU 和主内存带宽,然后在将实际数据写入磁盘时消耗额外的总线带宽,因为您不仅仅写入数据,而且消耗了奇偶校验。读取只需要读取数据而不是奇偶校验,除非该阵列处于降级状态。因此,读取对驱动器和跨计算机总线的流量减少,以达到正常操作条件的数据传输量。

- 5 级

这是最常见的 RAID 类型。通过在一个阵列的所有成员磁盘中分布奇偶校验,RAID 5 解除了级别 4 中原有的写入瓶颈。唯一性能瓶颈是奇偶校验计算过程本身。在使用现代 CPU 和软件 RAID 时,这通常不会成为瓶颈,因为现代 CPU 可能会非常快速地生成奇偶校验。然而,如果您的软件 RAID5 阵列中有大量成员设备,且在所有设备间有大量的数据进行传输时,就可能出现瓶颈。

和级别 4 一样,级别 5 的性能也是非对称的,读性能会高于写的性能。RAID 5 的存储容量的计算方法与级别 4 的计算方法是一样的。

- 级别 6

如果数据的冗余性和保护性比性能更重要,且无法接受 RAID 1 的空间利用率低的问题,则通常会选择使用级别 6。级别 6 使用一个复杂的奇偶校验方式,可以在阵列中出现任意两个磁盘失败的情况下进行恢复。因为使用的奇偶校验方式比较复杂,软件 RAID 设备会对 CPU 造成较大负担,同时对写操作造成更大的负担。因此,与级别 4 和 5 相比,级别 6 的性能不对称性更严重。

RAID 6 阵列的总容量与 RAID 5 和 4 类似,但您必须从设备数量中减小两个(而不是 1 个)额外奇偶校验存储空间的设备数。

- 级别 10

这个 RAID 级别将级别 0 的性能优势与级别 1 的冗余合并。它还有助于减少在有多于 2 个设备时,级别 1 阵列中的利用率低的问题。在级别 10 中,可以创建一个 3 个驱动器阵列来只存储每个数据的 2 个副本,然后允许整个阵列的大小达到最小设备的 1.5 倍,而不是只等于最小设备(与有 3 个设备的级别 1 阵列相同)。与 RAID 级别 6 相比,计算奇偶校验对 CPU 的消耗较少,但空间效率较低。

在安装过程中,不支持创建 RAID 10。您可在安装后手动创建。

- 线性 RAID

线性 RAID 是创建更大的虚拟驱动器的一组驱动器。

在线性 RAID 中,块会被从一个成员驱动器中按顺序分配,只有在第一个完全填充时才会进入下一个驱动器。这个分组方法不会提供性能优势,因为 I/O 操作不太可能在不同成员间同时进行。线性 RAID 也不提供冗余性,并会降低可靠性。如果有任何一个成员驱动器失败,则无法使用整个阵列。该容量是所有成员磁盘的总量。

10.3. LVM RAID 片段类型

要创建一个 RAID 逻辑卷,在 lvcreate 命令中使用 --type 参数。下表描述了可能的 RAID 片段类型。

对于大多数用户,指定五个可用主类型之一(raid1、raid4、raid5、raid6、raid10)应该足够了。

表 10.1. LVM RAID 片段类型

| 片段类型 | 描述 |

|---|---|

|

|

RAID1 镜像。当您指定 |

|

| RAID4 专用奇偶校验磁盘 |

|

|

与 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

与 |

|

|

|

|

|

|

|

|

|

|

|

|

|

| 条带。RAID0 以条带大小的单位在多个数据子卷间分布逻辑卷数据。这可以提高性能。如果任何数据子卷失败,逻辑卷数据将会丢失。 |

10.4. 创建 RAID 逻辑卷

这部分提供了创建不同类型的 RAID 逻辑卷的命令示例。

您可以根据您为 -m 参数指定的值创建带有不同副本数的 RAID1 阵列。同样,您可以使用 -i argument 为 RAID 4,5,6 逻辑卷指定条带数目。您还可以使用 -I 参数指定条带的大小。

下面的命令在卷组 my_vg 中创建了名为 my_lv 的双向 RAID1 阵列,大小为 1GB。

# lvcreate --type raid1 -m 1 -L 1G -n my_lv my_vg

下面的命令在卷组 my_vg 中创建了名为 my_lv 的 RAID5 阵列(3 条带 + 1 个隐式奇偶校验驱动器),该阵列大小为 1GB。请注意,您可以像您为 LVM 条状卷一样指定条带的数目,自动添加正确的奇偶校验驱动器数目。

# lvcreate --type raid5 -i 3 -L 1G -n my_lv my_vg

下面的命令在卷组 my_vg 中创建了名为 my_lv 的 RAID6 阵列(3 条带 + 2 个隐式奇偶校验驱动器),该阵列大小为 1GB。

# lvcreate --type raid6 -i 3 -L 1G -n my_lv my_vg10.5. 创建 RAID0(条状)逻辑卷

RAID0 逻辑卷以条的大小为单位,将逻辑卷数据分散到多个数据子卷中。

创建 RAID0 卷的命令格式如下。

lvcreate --type raid0[_meta] --stripes Stripes --stripesize StripeSize VolumeGroup [PhysicalVolumePath ...]

表 10.2. RAID0 命令创建参数

| 参数 | 描述 |

|---|---|

|

|

指定 |

|

| 指定在其中分割逻辑卷的设备数。 |

|

| 以 KB 为单位指定每个条的大小。这是在移动到下一个设备前写入一个设备的数据量。 |

|

| 指定要使用的卷组。 |

|

| 指定要使用的设备。如果没有指定,LVM 会选择 Stripes 选项指定的设备数,每个条带一个。 |

这个示例步骤创建名为 mylv 的 LVM RAID0 逻辑卷,可在磁盘 /dev/sda1、/dev/sdb1 和 /dev/sdc1 跨磁盘条状分布数据。

使用

pvcreate命令将卷组中您要使用的磁盘标记为 LVM 物理卷。警告这个命令会破坏

/dev/sda1、/dev/sdb1和/dev/sdc1中的所有数据。#

pvcreate /dev/sda1 /dev/sdb1 /dev/sdc1Physical volume "/dev/sda1" successfully created Physical volume "/dev/sdb1" successfully created Physical volume "/dev/sdc1" successfully created创建卷组

myvg。下面的命令创建了卷组myvg。#

vgcreate myvg /dev/sda1 /dev/sdb1 /dev/sdc1Volume group "myvg" successfully created您可以使用

vgs命令显示新卷组的属性。#

vgsVG #PV #LV #SN Attr VSize VFree myvg 3 0 0 wz--n- 51.45G 51.45G从您创建的卷组中创建 RAID0 逻辑卷。以下命令从卷组

mylv中创建 RAID0 卷myvg。这个示例创建的逻辑卷大小为 2GB,有三个条带,条带的大小为 4KB。#

lvcreate --type raid0 -L 2G --stripes 3 --stripesize 4 -n mylv myvgRounding size 2.00 GiB (512 extents) up to stripe boundary size 2.00 GiB(513 extents). Logical volume "mylv" created.在 RAID0 逻辑卷中创建文件系统。下面的命令在逻辑卷中创建了一个

ext4文件系统。#

mkfs.ext4 /dev/myvg/mylvmke2fs 1.44.3 (10-July-2018) Creating filesystem with 525312 4k blocks and 131376 inodes Filesystem UUID: 9d4c0704-6028-450a-8b0a-8875358c0511 Superblock backups stored on blocks: 32768, 98304, 163840, 229376, 294912 Allocating group tables: done Writing inode tables: done Creating journal (16384 blocks): done Writing superblocks and filesystem accounting information: done下面的命令挂载逻辑卷并报告文件系统磁盘空间用量。

#

mount /dev/myvg/mylv /mnt#dfFilesystem 1K-blocks Used Available Use% Mounted on /dev/mapper/myvg-mylv 2002684 6168 1875072 1% /mnt

10.6. 使用带有 RAID LV 的 DM 完整性功能

当设备失败时,RAID 可以帮助防止数据丢失,使用带有 RAID LV 的 DM 完整性功能可降低 RAID 设备中数据丢失的风险。请阅读本节来进一步了解如何通过 DM 完整性功能来保护数据不受破坏。

10.6.1. 使用 DM 完整性保护数据

根据配置类型,RAID LV 可防止设备失败时数据丢失。如果由 RAID 阵列组成的设备失败,这些数据可从 RAID LV 一部分的其它设备中恢复。但是 RAID 配置不能保证数据本身的完整性。软崩溃、静默崩溃、软错误和静默错误用来描述,即使系统和软件仍继续按预期工作,但数据已损坏的情况的术语。

数据存储中的软崩溃意味着,从存储设备中检索的数据与写入到那个设备中的数据不同。错误的数据可以在存储设备中无限期存在。在检索并尝试使用此数据之前,您可能不会发现这些数据已被损坏。

完整性用于 RAID 级别 1、4、5、6 和 10,以帮助缓解或防止软崩溃造成数据丢失。RAID 层确保了没有检测到的数据副本可以修复软崩溃的错误。完整性层位于每个 RAID 镜像之上,同时附加子 LV 存储每个 RAID 镜像的完整性元数据(数据校验和)。当您从带有完整性的 RAID LV 中检索数据时,完整性数据校验和会分析崩溃的数据。如果检测到崩溃,完整性层会返回一个错误消息,RAID 层会从另一个 RAID 镜像检索到非破坏的数据副本。RAID 层会在损坏的数据中自动重写非破坏的数据,以修复软崩溃。

您可在在创建 RAID LV 时添加 DM 完整性,或者向已存在的 RAID LV 中添加 DM 完整性。当在创建 RAID LV 时添加完整性,或在现有文件中添加完整性时,需要额外的存储空间来保存完整性元数据。对于每个 RAID 镜像,为了保存完整性元数据,每 500MB 数据都需要 4MB 的额外存储空间。

10.6.1.1. 添加 DM 完整性时的注意事项

当创建一个带有 DM 完整性的 RAID LV 或向已存在的 RAID LV 中添加完整性时,需要考虑某些注意事项:

- DM 完整性需要额外的存储空间,因为它需要在数据中添加校验和。

- 添加 DM 完整性会因为访问数时延迟而影响到性能,有些 RAID 的配置会比其他 RAID 配置受到的影响更大。RAID1 配置通常比 RAID5 或其变体提供更好的性能。

- RAID 完整性块的大小也会影响性能。配置更大的 RAID 完整块可提供更好的性能。但是,一个较小的 RAID 完整性块可以提供更好的兼容性。

- 完整性有两种模式:位图(bitmap)或日志(journal)。位图模式通常比日志模式提供更好的性能。

如果您遇到性能问题,建议您使用带有完整性的 RAID1,或者测试某个 RAID 配置的性能以确保它满足您的要求。

10.6.2. 创建带有 DM 完整性的 RAID LV

当您创建 RAID LV 后,添加 DM 完整性有助于降低因为软崩溃而丢失数据的风险。

先决条件

- 您必须有 root 访问权限。

流程

要创建带 DM 完整性的 RAID LV,运行以下命令:

# lvcreate --type <raid-level> --raidintegrity y -L <usable-size> -n <logical-volume> <volume-group>其中

<raid-level>- 指定您要创建的 RAID LV 的 RAID 级别。

<usable-size>- 以 MB 为单位指定可用大小。

<logical-volume>- 指定您要创建的 LV 的名称。

<volume-group>- 指定要在其中创建 RAID LV 的卷组名称。

在下面的例子中,在 test-vg 卷组中创建一个名为 test-lv 的带有完整性的 RAID LV,可用大小为 256M,使用 RAID 1。

带有完整性的 RAID LV 示例

# lvcreate --type raid1 --raidintegrity y -L256M -n test-lv test-vg Creating integrity metadata LV test-lv_rimage_0_imeta with size 8.00 MiB. Logical volume "test-lv_rimage_0_imeta" created. Creating integrity metadata LV test-lv_rimage_1_imeta with size 8.00 MiB. Logical volume "test-lv_rimage_1_imeta" created. Logical volume "test-lv" created.

10.6.3. 在现有的 RAID LV 中添加 DM 完整性

您可以在现有的 RAID LV 中添加 DM 完整性,以帮助降低因为软崩溃而丢失数据的风险。

先决条件

- 您必须有 root 访问权限。

流程

要在现有的 RAID LV 中添加 DM 完整性,请运行以下命令:

# lvconvert --raidintegrity y <volume-group>/<logical-volume>其中

<volume-group>- 指定要在其中创建 RAID LV 的卷组名称。

<logical-volume>- 指定您要创建的 LV 的名称。

10.6.4. 从 RAID LV 中删除完整性

在 RAID LV 中添加完整性限制了您可以在那个 RAID LV 上执行的一些操作。因此,您必须在执行某些操作前删除完整性。

先决条件

- 您必须有 root 访问权限。

流程

要从 RAID LV 中删除完整性,请运行以下命令:

# lvconvert --raidintegrity n <volume-group>/<logical-volume>其中

<volume-group>- 指定要在其中创建 RAID LV 的卷组名称。

<logical-volume>- 指定您要创建的 LV 的名称。

10.6.5. 查看 DM 完整性信息

当您创建有完整性的 RAID LVS 或者在现有 RAID LV 中添加完整性时,使用以下命令查看有关完整性的信息:

# lvs -a <volume-group>

这里的 <volume-group> 是包含有完整性的 RAID LV 的卷组名称。

以下示例显示在 test-vg 卷组中创建的 test-lv RAID LV 的信息。

# lvs -a test-vg LV VG Attr LSize Origin Cpy%Sync test-lv test-vg rwi-a-r--- 256.00m 2.10 [test-lv_rimage_0] test-vg gwi-aor--- 256.00m [test-lv_rimage_0_iorig] 93.75 [test-lv_rimage_0_imeta] test-vg ewi-ao---- 8.00m [test-lv_rimage_0_iorig] test-vg -wi-ao---- 256.00m [test-lv_rimage_1] test-vg gwi-aor--- 256.00m [test-lv_rimage_1_iorig] 85.94 [test-lv_rimage_1_imeta] test-vg ewi-ao---- 8.00m [test-lv_rimage_1_iorig] test-vg -wi-ao---- 256.00m [test-lv_rmeta_0] test-vg ewi-aor--- 4.00m [test-lv_rmeta_1] test-vg ewi-aor--- 4.00m

同步

当您创建一个带有完整性的 RAID LVS 或者在现有 RAID LV 中添加完整性时,我们建议您在使用 LV 前等待完整性同步和 RAID 元数据完成。否则,在后台进行的初始化可能会影响 LV 的性能。Cpy%Sync 列显示了顶层 RAID LV 和每个 RAID 镜像的同步进度。RAID 镜像在 LV 列中由 raid_image_N 显示。请参考 LV 列以确定同步进度显示顶层 RAID LV 以及每个 RAID 镜像的 100%。

使用完整性的 RAID 镜像

在 Attr 列中列出的属性中的 g 属性表示 RAID 镜像使用了完整性。完整性校验和保存在 _imeta RAID LV 中。

要显示每个 RAID LV 的类型,在 lvs 命令中添加 -o+segtype 选项:

# lvs -a my-vg -o+segtype LV VG Attr LSize Origin Cpy%Sync Type test-lv test-vg rwi-a-r--- 256.00m 87.96 raid1 [test-lv_rimage_0] test-vg gwi-aor--- 256.00m [test-lv_rimage_0_iorig] 100.00 integrity [test-lv_rimage_0_imeta] test-vg ewi-ao---- 8.00m linear [test-lv_rimage_0_iorig] test-vg -wi-ao---- 256.00m linear [test-lv_rimage_1] test-vg gwi-aor--- 256.00m [test-lv_rimage_1_iorig] 100.00 integrity [test-lv_rimage_1_imeta] test-vg ewi-ao---- 8.00m linear [test-lv_rimage_1_iorig] test-vg -wi-ao---- 256.00m linear [test-lv_rmeta_0] test-vg ewi-aor--- 4.00m linear [test-lv_rmeta_1] test-vg ewi-aor--- 4.00m linear

完整性不匹配

有一个增量的计数器,它计算在每个 RAID 镜像上检测到的不匹配数。要查看特定 RAID 镜像的完整性所检测到的数据不匹配,运行以下命令:

# lvs -o+integritymismatches <volume-group>/<logical-volume>_raid-image_<n>

其中

<volume-group>- 指定要在其中创建 RAID LV 的卷组名称。

<logical-volume>- 指定您要创建的 LV 的名称。

<n>- 指定您要查看完整性不匹配信息的 RAID 镜像。

您必须为每个要查看的 RAID 镜像运行该命令。在以下示例中,可以查看 test-vg/test-lv 下的 rimage_0 来查看数据不匹配的信息。

# lvs -o+integritymismatches test-vg/test-lv_rimage_0 LV VG Attr LSize Origin Cpy%Sync IntegMismatches [test-lv_rimage_0] test-vg gwi-aor--- 256.00m [test-lv_rimage_0_iorig] 100.00 0

可以看到,完整性还没有检测到任何不匹配的数据,因此 IntegMismatches 计数器会显示零(0)。

内核消息日志中的完整性不匹配

您还可以在内核消息日志中找到数据完整性信息,如下例所示。

与内核消息日志不匹配的 dm-integrity 示例

device-mapper: integrity: dm-12: Checksum failed at sector 0x24e7

内核消息日志中的 dm-integrity 数据修正示例

md/raid1:mdX: read error corrected (8 sectors at 9448 on dm-16)

10.6.6. 其它资源

-

有关所有可用选项的详情请参考

lvmraid命令 man page。

10.7. 控制 RAID 卷初始化的频率

当创建 RAID10 逻辑卷时,使用 sync 操作初始化逻辑卷所需的后台 I/O 可在 LVM 设备中分离其他 I/O 操作,比如卷组元数据更新,特别是在您创建多个 RAID 逻辑卷时。这会导致其它 LVM 操作速度下降。

您可以通过实施恢复节流来控制初始化 RAID 逻辑卷的速度。您可以通过使用 lvcreate 命令的 --minrecoveryrate 和 --maxrecoveryrate 选项为那些操作设置最小和最大 I/O 速率来控制执行 sync 操作的速率。如下所示指定这些选项。

--maxrecoveryrate Rate[bBsSkKmMgG]为 RAID 逻辑卷设置最大恢复率,使其不会阻断其他小的 I/O 操作。这个比率被指定为“数量/每秒/阵列中的每个设备”。如果没有给出后缀,则会假定为 kiB/sec/device。将恢复率设置为 0 表示它将不被绑定。

--minrecoveryrate Rate[bBsSkKmMgG]为 RAID 逻辑卷设置最小恢复率来确保

sync操作的 I/O 获得最小吞吐量,即使存在大量 I/O。这个比率被指定为“数量/每秒/阵列中的每个设备”。如果没有给出后缀,则会假定为 kiB/sec/device。

下面的命令创建了双向 RAID10 阵列,有三个条带,大小为 10GB,最大恢复率为 128 kiB/sec/device。这个数组名为 my_lv,且位于卷组 my_vg 中。

# lvcreate --type raid10 -i 2 -m 1 -L 10G --maxrecoveryrate 128 -n my_lv my_vg您还可以为 RAID 清理操作指定最小和最大恢复率。

10.8. 将线性设备转换为 RAID 设备

您可以使用 lvconvert 命令的 --type 参数将现有线性逻辑卷转换成 RAID 设备。

下面的命令将卷组 my_vg 中的线性逻辑卷 my_lv 转换为双向 RAID1 阵列。

# lvconvert --type raid1 -m 1 my_vg/my_lv因为 RAID 逻辑卷由元数据和数据子卷对组成,因此当您将线性设备转换成 RAID1 阵列时,会生成一个新的元数据子卷,并关联到线性卷所在的同一物理卷中的原始逻辑卷之一。额外的镜像在 metadata/data 子卷对中添加。例如:如果原始设备如下:

# lvs -a -o name,copy_percent,devices my_vg

LV Copy% Devices

my_lv /dev/sde1(0)转换为双向 RAID1 阵列后,该设备包含以下数据和元数据子卷对:

#lvconvert --type raid1 -m 1 my_vg/my_lv#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 6.25 my_lv_rimage_0(0),my_lv_rimage_1(0) [my_lv_rimage_0] /dev/sde1(0) [my_lv_rimage_1] /dev/sdf1(1) [my_lv_rmeta_0] /dev/sde1(256) [my_lv_rmeta_1] /dev/sdf1(0)

如果无法将与原始逻辑卷对映的元数据镜像放在同一个物理卷中, lvconvert 将失败。

10.9. 将 LVM RAID1 逻辑卷转换为 LVM 线性逻辑卷

您可以使用 lvconvert 命令将现有 RAID1 LVM 逻辑卷转换为 LVM 线性逻辑卷,方法是指定 -m0 参数。这会删除所有 RAID 数据子卷以及构成 RAID 阵列的所有 RAID 元数据子卷,保留顶层 RAID1 镜像作为线性逻辑卷。

下面的例子显示了现有的 LVM RAID1 逻辑卷。

# lvs -a -o name,copy_percent,devices my_vg

LV Copy% Devices

my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0)

[my_lv_rimage_0] /dev/sde1(1)

[my_lv_rimage_1] /dev/sdf1(1)

[my_lv_rmeta_0] /dev/sde1(0)

[my_lv_rmeta_1] /dev/sdf1(0)

下面的命令可将 LVM RAID1 逻辑卷 my_vg/my_lv 转换成 LVM 线性设备。

#lvconvert -m0 my_vg/my_lv#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv /dev/sde1(1)

当您将 LVM RAID1 逻辑卷转换成 LVM 线性卷,,您可以指定要删除的物理卷。以下示例显示了由两个镜像组成的 LVM RAID1 逻辑卷布局: /dev/sda1 和 /dev/sdb1。在这个示例中, lvconvert 命令指定要删除 /dev/sda1,并将 /dev/sdb1 保留为组成线性设备的物理卷。

#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0) [my_lv_rimage_0] /dev/sda1(1) [my_lv_rimage_1] /dev/sdb1(1) [my_lv_rmeta_0] /dev/sda1(0) [my_lv_rmeta_1] /dev/sdb1(0) #lvconvert -m0 my_vg/my_lv /dev/sda1#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv /dev/sdb1(1)

10.10. 将镜像 LVM 设备转换为 RAID1 设备

您可以通过指定 --type raid1 参数来使用 lvconvert 命令将现有镜像的片段类型为 mirror 的 LVM 设备转换为 RAID1 LVM 设备。这会将镜像子卷(mimage)重命名为 RAID 子卷(rimage)。另外,镜像日志也会被删除,同时为与对应的数据子卷相同的物理卷中的数据子卷创建元数据子卷(rmeta)。

下面的例子显示了镜像逻辑卷 my_vg/my_lv 的布局。

# lvs -a -o name,copy_percent,devices my_vg

LV Copy% Devices

my_lv 15.20 my_lv_mimage_0(0),my_lv_mimage_1(0)

[my_lv_mimage_0] /dev/sde1(0)

[my_lv_mimage_1] /dev/sdf1(0)

[my_lv_mlog] /dev/sdd1(0)

下面的命令可将镜像逻辑卷 my_vg/my_lv 转换为 RAID1 逻辑卷。

#lvconvert --type raid1 my_vg/my_lv#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0) [my_lv_rimage_0] /dev/sde1(0) [my_lv_rimage_1] /dev/sdf1(0) [my_lv_rmeta_0] /dev/sde1(125) [my_lv_rmeta_1] /dev/sdf1(125)

10.11. 重新定义 RAID 逻辑卷大小

您可以使用以下方法重新定义 RAID 逻辑卷大小:

-

您可以使用

lvresize或者lvextend命令增大任意类型的 RAID 逻辑卷的大小。这不会改变 RAID 镜像的数量。对于条带的 RAID 逻辑卷,创建条带 RAID 逻辑卷时可使用同样的条状限制。

-

您可以使用

lvresize或者lvreduce命令减少任意类型的 RAID 逻辑卷的大小。这不会改变 RAID 镜像的数量。和lvextend命令一样,使用与创建条状 RAID 逻辑卷相同的条状限制。

-

您可以使用

lvconvert命令的--stripes N参数更改条状 RAID 逻辑卷(raid4/5/6/10)中的条状数量。这会根据增加或删除条的大小来增加或者减少 RAID 逻辑卷的大小。请注意,raid10卷只能添加条带。这个能力是 RAID reshaping 功能的一部分,它允许您在保持相同的 RAID 级别的情况下修改 RAID 逻辑卷的属性。有关 RAID 重新性能以及使用lvconvert命令重新定义 RAID 逻辑卷的示例,请参考lvmraid(7)手册页。

10.12. 更改现有 RAID1 设备中的镜像数

您可以更改现有 RAID1 阵列中的镜像数量,就如同在早期的 LVM 镜像部署中更改镜像数量。使用 lvconvert 命令指定要添加或删除的额外元数据/数据子卷对数。

当您使用 lvconvert 命令向 RAID1 设备添加镜像时,您可以指定所生成设备的镜像总数,或者您可以指定要添加到该设备中的镜像数。您还可以有选择地指定新元数据/数据镜像对所在的物理卷。

元数据子卷(名为 rmeta)始终存在于与其数据子卷 rimage相同的物理设备中。元数据/数据子卷对不会在与 RAID 阵列中其它元数据/数据子卷对相同的物理卷中创建(除非您指定了 --alloc anywhere)。

在 RAID1 卷中添加镜像的命令格式如下:

lvconvert -m new_absolute_count vg/lv [removable_PVs] lvconvert -m +num_additional_images vg/lv [removable_PVs]

例如:以下命令显示 LVM 设备 my_vg/my_lv,它是一个双向 RAID1 阵列:

# lvs -a -o name,copy_percent,devices my_vg

LV Copy% Devices

my_lv 6.25 my_lv_rimage_0(0),my_lv_rimage_1(0)

[my_lv_rimage_0] /dev/sde1(0)

[my_lv_rimage_1] /dev/sdf1(1)

[my_lv_rmeta_0] /dev/sde1(256)

[my_lv_rmeta_1] /dev/sdf1(0)

以下命令可将双向 RAID1 设备 my_vg/my_lv 转换为三向 RAID1 设备:

#lvconvert -m 2 my_vg/my_lv#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 6.25 my_lv_rimage_0(0),my_lv_rimage_1(0),my_lv_rimage_2(0) [my_lv_rimage_0] /dev/sde1(0) [my_lv_rimage_1] /dev/sdf1(1) [my_lv_rimage_2] /dev/sdg1(1) [my_lv_rmeta_0] /dev/sde1(256) [my_lv_rmeta_1] /dev/sdf1(0) [my_lv_rmeta_2] /dev/sdg1(0)